基于局部和全局特征的电力设备红外和可见光图像匹配方法

冯旭刚1,2,3 阮善会3 王正兵1,2,3 安 硕3 张科琪3

(1. 安徽省智能破拆装备工程实验室(安徽工业大学) 马鞍山 243032 2. 安徽省工业互联网智能应用与安全工程研究中心(安徽工业大学) 马鞍山 243032 3. 安徽工业大学电气与信息工程学院 马鞍山 243032)

摘要 针对电力设备红外和可见光图像匹配过程受图像局部灰度差异影响大,以及特征点描述和匹配困难的问题,该文提出了基于局部和全局特征的电力设备红外和可见光图像匹配方法。首先,利用多尺度角检测算法分别检测红外和可见光图像中的特征点,再使用不同尺度的曲率信息为每个特征点分配特征主方向(CAO);其次,分别构建每个特征点的部分灰度不变特征描述符(PIIFD)和全局上下文特征描述符;然后,将两种特征描述符的相似度进行加权融合,并利用双向匹配方法和随机抽样一致(RANSAC)方法筛选出正确的匹配点对;最后,得到图像间的仿射变换模型参数。实验结果表明:该文匹配方法与PIIFD、Log-Gabor直方图描述符(LGHD)和CAO匹配算法相比,正确匹配数显著增加,平均准确率较其他三种算法分别提高了50.71、27.62、11.11个百分点,平均重复度分别提高了27.69、28.81、19.18个百分点。

关键词:电力设备 图像匹配 红外和可见光图像 全局上下文描述符 特征相似度匹配

0 引言

电力设备是电力系统的重要组成部分之一,监测电力设备的运行状态已成为满足生产生活用电需求的关键环节。鉴于电力设备持续运行的特性,当其出现故障时最直观的表现便是温度的异常。因此,大量的巡检机器人和运维无人机被用于捕获电力设备的红外和可见光图像,通过融合这些图像实现对电力设备运行状态的自动分析和监测[1-6]。电力设备的红外和可见光图像可以提供相关区域的互补信息[7],将两者匹配是为了将不同传感器在不同时间和地点采集的图像进行配准对齐,进而更好地分析和监测电力设备状态。

目前的异源图像匹配算法可概括为基于区域和基于特征两种主要类型[8]。基于区域的方法直接对局部图像灰度进行相似性评价以预测图像之间的对应关系[9],常见的有互信息和归一化互相关系数[10],这些方法被广泛应用于医学图像处理中。然而,这些方法计算复杂度高,只适用于图像之间具有平移变换和几何变形的情况,对图像间的旋转、尺度以及光照变化缺乏鲁棒性。相比之下,基于特征的方法计算效率更高,对异源图像匹配中的复杂场景具有更好的鲁棒性,因而得到广泛的研究和应用。文献[11]提出一种一致稳健的尺度不变特征变换匹配(Uniform Robust Scale Invariant Feature Transform, UR-SIFT)算法,采用基于熵值的特征选取策略从图像中提取均匀分布的特征点来进行特征匹配。文献[12]提出了一种快速鲁棒性特征(Speeded Up Robust Feature, SURF)的方法,该方法旨在提高图像匹配的鲁棒性和计算效率。文献[13]将原始尺度不变特征变换匹配(Scale Invariant Feature Transform, SIFT)算法扩展到多模态视网膜图像匹配,并提出一种部分灰度不变特征描述符(Partial Intensity Invariant Feature Descriptor, PIIFD),以应对红外图像和可见光图像之间的灰度差异问题,该方法已广泛应用于红外和可见光图像匹配[14-15]。文献[16]采用曲率尺度空间(Curvature Scale Space, CSS)算法提取边缘特征点,结合SIFT描述算子实现图像配准。文献[17]在此基础上,提出以轮廓中线为特征主方向(Contour Angle Orientation, CAO),提高了旋转尺度变化下电力设备红外与可见光图像的配准精度,但匹配结果的重复度不高。为了更好地克服图像间非线性灰度变化的问题,文献[18]提出从相位一致性图中提取点特征,以此构造更加稳定的特征描述符用于多模图像匹配。文献[19]引入了Log-Gabor直方图描述符(Log-Gabor Histogram Descriptor, LGHD),对非线性强度变化具有较强的鲁棒性。文献[20]引入了辐射不变特征变换(Radiation-variation Insensitive Feature Transform, RIFT)的新方法,它利用相位一致性图提取关键点,并构造一种极大索引图进行特征描述。上述现有的特征匹配方法主要利用局部图像信息来构造特征描述符,由于成像机理不同,异源图像的局部信息也存在较大差异。因此,基于此构造的特征描述符可能会受到局部图像信息差异的影响,导致红外和可见光图像匹配的准确率不高。

随着计算机硬件性能的提高,应用深度学习网络来实现图像匹配逐渐成为研究热点。例如,文献[21]提出一种采用自监督方式训练的SuperPoint网络,实现对特征点的检测并进行描述。在特征匹配阶段,文献[22]搭建了SuperGlue网络,基于注意力图神经网络将特征进行聚合从而得到图像匹配的对应关系。文献[23]在SuperGlue网络的基础上融合了聚类的思想,实现对SuperGlue网络的改进。于是,将SuperPoint和SuperGlue进行组合的匹配方法,在匹配同源图像上可以获得不错的效果,但在匹配异源图像上仍需改进提升。除此之外,基于深度学习的匹配方法需要大量的数据集来训练模型,在缺少数据集的实际情况下,此类方法的泛化能力有待增强。

针对以上问题,本文提出一种基于局部和全局特征的电力设备红外和可见光图像匹配方法。该方法首先通过基于算术平均 余弦曲率(Arithmetic Mean k-cosine Curvature, AMKC)的多尺度角检测算法,在图像的轮廓特征上提取具有尺度不变性的特征点,并利用特征点局部曲率计算特征点的主方向,提高匹配方法对尺度差异和旋转差异的鲁棒性;然后,分别计算每个特征点的PIIFD和全局上下文特征描述符,充分利用图像的局部特征和全局特征描述图像特征;最后,对两种特征描述符的相似度进行加权融合,利用相似度双向匹配方法和随机抽样一致(Random Sample Consensus, RANSAC)方法获取正确的匹配特征点对,进而得到图像间的仿射变换模型参数。

余弦曲率(Arithmetic Mean k-cosine Curvature, AMKC)的多尺度角检测算法,在图像的轮廓特征上提取具有尺度不变性的特征点,并利用特征点局部曲率计算特征点的主方向,提高匹配方法对尺度差异和旋转差异的鲁棒性;然后,分别计算每个特征点的PIIFD和全局上下文特征描述符,充分利用图像的局部特征和全局特征描述图像特征;最后,对两种特征描述符的相似度进行加权融合,利用相似度双向匹配方法和随机抽样一致(Random Sample Consensus, RANSAC)方法获取正确的匹配特征点对,进而得到图像间的仿射变换模型参数。

1 基于AMKC的多尺度角检测

电力设备红外和可见光图像的轮廓特征较为显著,提取电力设备轮廓特征后,通过计算轮廓曲率检测特征点。然而,通过局部梯度信息计算轮廓曲率会受到电力设备的红外和可见光图像局部灰度差异的影响;并且还需计算轮廓点在不同尺度下的曲率,计算复杂度较高,且检测出的特征点的数量较少。因此,本文改进 余弦曲率,快速实现多尺度角检测,在不同尺度下计算轮廓曲率并提取大量的特征点。

余弦曲率,快速实现多尺度角检测,在不同尺度下计算轮廓曲率并提取大量的特征点。

1.1 多尺度角检测

一幅图像中的边缘轮廓可用N个离散点坐标描述,定义为

式中, 为边缘轮廓上的点;

为边缘轮廓上的点; 为轮廓点

为轮廓点 的坐标。

的坐标。

设在尺度参数k下第 个点的曲率为

个点的曲率为 ,判定轮廓点是否为特征点的两个基本标准为:①

,判定轮廓点是否为特征点的两个基本标准为:① 是曲率的局部极大值;②

是曲率的局部极大值;② 大于给定阈值

大于给定阈值 。

。

单一尺度角检测方法是在一个具有固定半径的局部区域进行曲率估计的,在识别不同大小且具有相似特征的局部结构时,可能出现识别错误的情况。其存在的问题如图1所示,当局部区域的半径小于6个像素时,角A和角B会同时被识别为真角。

为了解决上述问题,文献[24-25]提出多尺度角检测方法,在多个尺度上计算曲率值,即在z个给定的尺度上进行曲率计算,分别记为 。将点

。将点 在z个尺度上的曲率分别记为

在z个尺度上的曲率分别记为

然后,利用多尺度下曲率的几何平均值作为点 处的曲率值,表示为

处的曲率值,表示为

(3)

(3)

由于多个尺度下曲率的几何平均值存在固有的数值问题,相比之下,用算术平均值来估计多尺度曲率更有效[26],即点 处曲率的计算公式为

处曲率的计算公式为

(4)

(4)

再利用识别角点的两个基本标准判定该点是否为角点。多尺度角检测通过对式(4)中计算的 的大小(即绝对值)应用阈值

的大小(即绝对值)应用阈值 来检测角特征。

来检测角特征。

1.2 AMKC多尺度角检测算法

为了实现图像轮廓曲线上每个点实际曲率的准确度量,文献[27]提出的 余弦是常用的度量标准之一,用于计算轮廓曲线的离散曲率。定义一个给定点

余弦是常用的度量标准之一,用于计算轮廓曲线的离散曲率。定义一个给定点 的

的 余弦曲率为

余弦曲率为

(6)

(6)

(7)

(7)

式中,向量 和

和 分别为点

分别为点 的前后k向量;“·”为点积运算;

的前后k向量;“·”为点积运算; 为向量

为向量 和

和 的夹角。

的夹角。

利用 余弦估计离散曲率的实质是通过点积运算,计算向量

余弦估计离散曲率的实质是通过点积运算,计算向量 和向量

和向量 夹角的余弦值近似估计离散曲率值。但事实上,通过

夹角的余弦值近似估计离散曲率值。但事实上,通过 余弦估计的离散曲率并没有准确地反映曲率的含义。例如,当轮廓上一个点的

余弦估计的离散曲率并没有准确地反映曲率的含义。例如,当轮廓上一个点的 余弦值为-1时,即向量

余弦值为-1时,即向量 和向量

和向量 方向相反时,计算出的离散曲率为

方向相反时,计算出的离散曲率为 ,但是实际点

,但是实际点 的曲率值为0。

的曲率值为0。

因此,本文通过设置曲率阈值改进了 余弦曲率,以解决上述使用

余弦曲率,以解决上述使用 余弦估计曲率时可能出现误估的问题。利用判定轮廓点时是否为特征点的第2条基本标准,设置曲率阈值下限为

余弦估计曲率时可能出现误估的问题。利用判定轮廓点时是否为特征点的第2条基本标准,设置曲率阈值下限为 。

。

基于以上定义,轮廓曲线上点 的算术平均

的算术平均 余弦曲率为

余弦曲率为

(8)

(8)

在绝大多数多尺度角检测方法中,选取的尺度数量越多,展现的性能越好。然而,在一定数量范围内,性能的提升与选取的数量之间存在边际效应,意味着随着选取尺度数量的增加,性能提升的效果会越来越不明显,然而计算量却随之上升。

因此,本文选取3个尺度计算边缘轮廓的算术平均 余弦曲率,3个尺度分别为

余弦曲率,3个尺度分别为 、

、 、

、 ,在展现较好性能的同时也没有加重计算负担,整体均衡性最好。3个尺度下的算术平均k余弦曲率计算示意图如图2所示。本文多尺度角检测中尺度的含义为计算轮廓点的

,在展现较好性能的同时也没有加重计算负担,整体均衡性最好。3个尺度下的算术平均k余弦曲率计算示意图如图2所示。本文多尺度角检测中尺度的含义为计算轮廓点的 余弦曲率时,轮廓点左右采样的像素间隔数。

余弦曲率时,轮廓点左右采样的像素间隔数。

1.3 AMKC特征点检测步骤

(1)给定输入图像,使用Canny边缘检测器进行边缘检测,得到二值边缘映射。

(2)从边缘图中提取轮廓,并对轮廓中的空白部分进行填补,然后检测T形结构。

(3)计算边缘曲线上每个点在三个不同尺度上的 余弦,再求取所得三个

余弦,再求取所得三个 余弦的算术平均值即为AMKC曲率。

余弦的算术平均值即为AMKC曲率。

(4)由判定角点的两个基本标准,先确定AMKC曲率的局部最大值来找到候选角;再将AMKC曲率值与预先设定的曲率阈值ε进行比较,在识别真角的同时剔除假角。

2 尺度不变特征和全局特征融合

2.1 基于曲率自适应加权的主方向分配

特征点主方向分配是基于点特征的匹配方法实现旋转不变性[28]时不可缺少的步骤。检测出曲线轮廓Γ的特征点后,应分配给每个特征点一个主方向。为了解决这一问题,本文提出了一种基于特征点的局部曲率信息来计算各个特征点主方向的鲁棒方法。

设 是在轮廓曲线Γ上检测到的一个特征点,为了确定特征点

是在轮廓曲线Γ上检测到的一个特征点,为了确定特征点 的主方向,首先计算其与

的主方向,首先计算其与 和

和 形成的合成向量,表示为

形成的合成向量,表示为

(10)

(10)

(11)

(11)

式中, 和

和 分别为轮廓上位于点

分别为轮廓上位于点 左右两侧且间隔为尺度

左右两侧且间隔为尺度 的点;

的点; 、

、 和

和 分别为轮廓上点

分别为轮廓上点 、

、 和

和 的坐标;

的坐标; 为尺度

为尺度 时的曲率权重因子,具体可计算为

时的曲率权重因子,具体可计算为

(12)

(12)

式中, 为特征点

为特征点 在尺度

在尺度 下的曲率。

下的曲率。

合成向量计算示意图如图3所示。然后,将每个尺度下的合成向量 累积为

累积为

本文将式(13)中获得的累积向量 的方向作为特征点

的方向作为特征点 的主要方向,记为

的主要方向,记为

2.2 部分灰度不变特征描述符(PIIFD)

对于红外和可见光图像匹配任务而言,经典的自然图像特征描述方法难以直接应用于图像特征描述中。原因在于红外和可见光图像的成像机理不同,导致两种图像的对应区域灰度差异较大,而传统的自然图像特征描述符易受图像间灰度差异的影响。因此本文采用PIIFD作为图像特征点的局部特征描述[29]。

为了计算特征点的PIIFD,本文选取特征点周围40×40的矩形区域构建特征描述符,并且选取特征点的主方向为矩形区域方向,以保证PIIFD的旋转不变性。

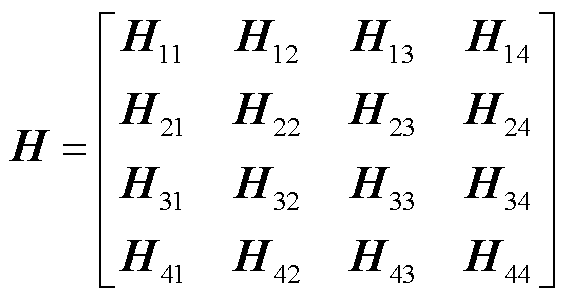

在计算PIIFD时,首先将整个矩形区域分割为4×4个子区域,对于单个子区域,计算其图像梯度的幅值和方向;然后将梯度幅值分段标准化以减小异源图像间梯度幅值变化带来的影响;最后生成具有16个均匀分布方向区间的方向直方图,并通过直方图中相反方向累加的方式将16个方向区间缩减为8个方向区间,由此可得整个矩形区域的描述为

式中, 为单个子区间的方向直方图。由于异源图像中对应特征点的主方向可能是相反的,需进一步采用矩阵线性组合法解决这一问题。设矩阵Q为将矩阵H旋转180°后得到的结果,则PIIFD定义为

为单个子区间的方向直方图。由于异源图像中对应特征点的主方向可能是相反的,需进一步采用矩阵线性组合法解决这一问题。设矩阵Q为将矩阵H旋转180°后得到的结果,则PIIFD定义为

(16)

(16)

式中, 和

和 分别为矩阵H和Q的第i行;r为调节参数。

分别为矩阵H和Q的第i行;r为调节参数。

2.3 全局上下文描述符

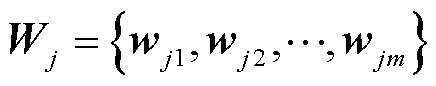

为了增强特征描述的鲁棒性,本文在PIIFD局部特征描述的基础上进一步引入全局上下文特征描述,该特征描述符利用特征点的几何属性进行构造[30-31],如图4所示。对于红色特征点 ,选定与

,选定与 的欧式距离最近的点为特征点,假定其个数为t,形成一个特征点集合,记为

的欧式距离最近的点为特征点,假定其个数为t,形成一个特征点集合,记为 。其中,t = λm,m为图像中检测到的所有特征点的个数,λ为平衡参数,本文中取值为0.7。

。其中,t = λm,m为图像中检测到的所有特征点的个数,λ为平衡参数,本文中取值为0.7。

特征点 与C中其他特征点的位置关系即为其全局上下文。具体而言,本文采用两个参数来描述特征点

与C中其他特征点的位置关系即为其全局上下文。具体而言,本文采用两个参数来描述特征点 和集合C中的特征点的位置关系:一个是向量

和集合C中的特征点的位置关系:一个是向量 与特征点

与特征点 主方向的夹角α;另一个是特征点

主方向的夹角α;另一个是特征点 主方向和特征点

主方向和特征点 主方向的夹角β。由此可得,图4中的红色特征点

主方向的夹角β。由此可得,图4中的红色特征点 与其邻域内的任一特征点

与其邻域内的任一特征点 的位置关系可由向量

的位置关系可由向量 表示,因此特征点的全局上下文描述可以表示为

表示,因此特征点的全局上下文描述可以表示为

为了方便计算,本文将 进一步化简为直方图,描述为

进一步化简为直方图,描述为

(18)

(18)

式中, 为特征点

为特征点 的全局上下文特征描述符;“#”为统计或计数,用于简化以形成直方图表示;bin(k)为直方图中第

的全局上下文特征描述符;“#”为统计或计数,用于简化以形成直方图表示;bin(k)为直方图中第 个值对应的角度区间。在本文算法中,夹角α的取值范围为[0, 2π],用8个区间等分;夹角β的取值范围为[0, π],用4个区间等分。

个值对应的角度区间。在本文算法中,夹角α的取值范围为[0, 2π],用8个区间等分;夹角β的取值范围为[0, π],用4个区间等分。

3 特征匹配

3.1 相似度双向匹配和误匹配剔除

在特征匹配阶段,本文通过计算红外和可见光图像中各个特征描述符的相似度来确定图像之间的最佳匹配点对。在本文算法中,特征描述符的相似度定义为

式中, 和

和 为两个特征点的特征描述符。将两个特征点的PIIFD代入式(19)可得局部相似度,记为

为两个特征点的特征描述符。将两个特征点的PIIFD代入式(19)可得局部相似度,记为 ;将其全局上下文特征描述符代入式(19)可得全局相似度,记为

;将其全局上下文特征描述符代入式(19)可得全局相似度,记为 ,则该特征点对之间的相似度可定义为

,则该特征点对之间的相似度可定义为

(20)

(20)

式中,γ为局部相似度和全局相似度之间的平衡因子,在本文方法中, =0.7。

=0.7。

设 和

和 是从图像中提取的特征点集合,前者来源于参考图像,后者来源于待匹配图像。根据式(19)所定义的相似度,可以构建两组特征点的初始对应关系。本文算法确定两幅图像中的最佳匹配点对采用的策略是双向匹配,只有当点

是从图像中提取的特征点集合,前者来源于参考图像,后者来源于待匹配图像。根据式(19)所定义的相似度,可以构建两组特征点的初始对应关系。本文算法确定两幅图像中的最佳匹配点对采用的策略是双向匹配,只有当点 在参考图像中与点

在参考图像中与点 的相似度最高,同时点

的相似度最高,同时点 在待匹配图像中与点

在待匹配图像中与点 的相似度也最高时,才将

的相似度也最高时,才将 和

和 选定为最佳匹配点对。双向匹配策略虽然有可能滤除少量的正样本,但是能够保证选定的最佳匹配点对具有较高的正确率。

选定为最佳匹配点对。双向匹配策略虽然有可能滤除少量的正样本,但是能够保证选定的最佳匹配点对具有较高的正确率。

采用双向匹配策略进行初步匹配后,匹配结果中仍然包含一定数量的误匹配。为了去除初始匹配结果中的误匹配,本文在初始匹配结果的基础上,采用RANSAC算法,计算两幅图像之间的转换矩阵,目的是将不符合转换矩阵关系的初始匹配点对视为误匹配并进行剔除。

3.2 匹配流程

本文提出的匹配算法流程如图5所示,具体描述如下。

1)输入图像:分别输入需要匹配的可见光图像和红外图像。

2)图像预处理:对输入的红外和可见光图像进行灰度处理,将灰度值线性变换至区间0~255,再利用图像最大像素值将灰度图像的灰度值标准化至区间0~1。

3)特征提取:使用Canny算法提取图像中的显著轮廓特征,再通过基于AMKC的多尺度角检测算法分别检测两幅图像中的特征点,并利用特征点局部曲率计算特征点的主方向。

4)建立特征描述符:对红外和可见光图像中的每个特征点,分别建立PIIFD和全局上下文描述符作为特征点的特征描述。

5)相似度双向匹配:使用本文提出的相似度双向匹配方法,先计算两幅图像中每一对特征点对间的相似度,再通过双向匹配筛选初步匹配结果。

6)最终匹配:使用RANSAC方法获取最终的匹配特征点对,进而得到图像间的仿射变换模型参数。

4 匹配实验结果与分析

4.1 实验环境

本文实验基于Intel(R) Core(TM) i7-13700H CPU@2.40 GHz硬件平台和Matlab R2022a软件平台。本文算法为Matlab编程代码。实验数据为Fotric热像仪采集的电力设备红外和可见光图像,其中红外图像分辨率为1 280×960,可见光图像分辨率为1 600×1 200。由于采集的图像中存在采集设备的名称、拍摄时间和色卡等界面信息,因此截取1 000×800的区域作为本文实验数据集[32]。

4.2 实验评价指标

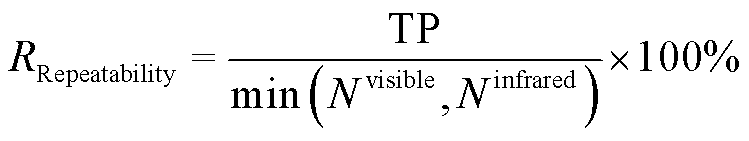

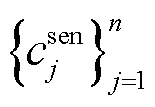

为了评估本文算法的性能,实验采用正确匹配数(Number of Correct Matches, NCM)、准确率(Precision)和重复度(Repeatability)三个评价指标对算法进行评定,其定义分别为

(21)

(21)

(23)

(23)

式中,TP为算法正确匹配点数;FP为算法非正确匹配点数; 为可见光图像中提取的特征点数量;

为可见光图像中提取的特征点数量; 为红外图像中提取的特征点数量。

为红外图像中提取的特征点数量。

为区分匹配结果的正确性,本文通过手动标定的变换矩阵计算每对匹配点之间的投影残差,将投影残差小于8的匹配点对视为正确匹配[17]。

4.3 实验匹配结果

4.3.1 全局特征修正局部特征有效性验证

本文采用全局上下文特征对PIIFD局部特征进行修正,为验证此方法的有效性,调整了平衡因子γ的大小,即调整全局上下文特征所占比例。平衡因子寻优实验结果如图6所示。图6中,NCM和RPrecision分别为本文算法匹配10组图像在不同平衡因子下的平均正确匹配点数量和平均准确率。由图6可见,提供全局信息有助于减少局部差异带来的影响,这两个指标随着γ值的增加呈上升趋势,并且当γ = 0.7时,匹配效果最佳。因此,本文将平衡因子设定为0.7。

4.3.2 图像无明显差异时的有效性验证

表1给出了LGHD、PIIFD、CAO和本文所提算法下的10组红外和可见光图像的匹配结果。从结果可以看出,本文算法成功地匹配了10组图像,平均准确率为93.41%,且正确匹配点数量和重复度指标均为最优,平均准确率较PIIFD、LGHD和CAO方法分别提高了50.71、27.62、11.11个百分点,平均重复度分别提高了27.69、28.81、19.18个百分点。与CAO方法相比,同样采用轮廓曲率的特征提取方法,本文提出的方法检测的特征点重复度更高;相比于PIIFD方法和LGHD方法,本文算法定位的准确度更高,进一步验证了局部和全局共同描述方法的优越性。

为了直观地展示本文算法的匹配效果,图7展示了通过本文方法成功匹配10组图像的结果。综合来看,本文算法能够在保证准确率的同时,检测出大量的正确匹配点对,并且具有较强的匹配点正误区分能力。

表1 不同匹配方法的匹配结果对比

Tab.1 Comparison of matching results of different matching methods

评价指标对比算法第1组第2组第3组第4组第5组第6组第7组第8组第9组第10组 NCMLGHD50246422969 PIIFD3908550585112517938 CAO51101814775443114216870 本文621831591705513566367365140 RPrecision(%)LGHD87.5040.075.066.766.795.781.854.590.0 PIIFD46.6060.361.744.730.035.344.051.652.8 CAO66.795.195.381.575.948.574.395.996.093.8 本文95.497.999.492.790.289.783.594.699.890.9 RRepeatability(%)LGHD1.901.92.77.83.622.71.61.04.3 PIIFD6.5010.28.17.83.62.95.78.45.5 CAO11.616.517.813.514.25.19.218.916.320.7 本文14.425.148.362.019.014.627.448.246.030.6

4.3.3 图像发生尺度变化时的鲁棒性验证

为测试本文算法在匹配图像发生尺度变化情况下的鲁棒性,先将10组图像中的红外图像分别缩小至原图的0.9、0.8、0.7、0.6,作为发生尺度变化后的红外图像,然后与原可见光图像进行匹配。将缩小比例记为尺度发生变化时的尺度因子fScale。本文算法对不同尺度差异的图像对进行匹配的性能结果如图8所示。可以看出,当fScale>0.7时,本文方法的性能保持稳定,但指标通常会随着尺度因子的降低而下降。这是因为从低空间分辨率图像中提取的特征点数量较少,可能会导致图像对之间的特征检测结果的重复性较低。本文所提方法与0.7尺度因子的匹配实例如图9所示。由此可以发现,所提出的基于AMKC的多尺度角检测方法对图像尺度变化具有鲁棒性。

4.3.4 图像发生旋转变化时的鲁棒性验证

为测试本文算法在匹配图像发生旋转变化时的鲁棒性,对4组红外图像顺时针旋转一定角度后与可见光图像进行匹配。图10和表2分别为旋转20°时采用本文算法匹配的直观视觉结果和评价指标。由结果可知,本文提出的基于曲率自适应加权的主方向分配方法,在图像对之间发生小角度旋转时具有一定的鲁棒性。

表2 旋转角度为20°时本文算法的匹配结果

Tab.2 The matching results of the proposed algorithm with 20° rotated angle

评价指标第1组第2组第3组第4组 NCM75866142 RPrecision(%)95.391.589.185.7 RRepeatability(%)11.415.312.014.3

5 结论

本文提出了一种基于局部和全局特征的电力设备红外和可见光图像匹配方法。实验结果表明:改进后的 余弦曲率可以准确地反映曲率含义,通过多尺度算术平均曲率特征检测,可以提取大量精度高且具有尺度不变性的特征点;而利用多尺度曲率信息分配特征点主方向,具有一定的旋转不变性;通过提出全局上下文信息结合局部特征信息的特征描述方法,有效地消除了局部灰度差异对匹配结果的影响,实现了具有尺度不变性的红外和可见光图像匹配。所提方法的平均准确率为93.41%,平均重复率为33.56%,验证了本文匹配方法能够有效地匹配电力设备红外和可见光图像。

余弦曲率可以准确地反映曲率含义,通过多尺度算术平均曲率特征检测,可以提取大量精度高且具有尺度不变性的特征点;而利用多尺度曲率信息分配特征点主方向,具有一定的旋转不变性;通过提出全局上下文信息结合局部特征信息的特征描述方法,有效地消除了局部灰度差异对匹配结果的影响,实现了具有尺度不变性的红外和可见光图像匹配。所提方法的平均准确率为93.41%,平均重复率为33.56%,验证了本文匹配方法能够有效地匹配电力设备红外和可见光图像。

参考文献

[1] 韩翔宇, 纽春萍, 何海龙, 等. 电磁式断路器状态监测与智能评估技术综述[J]. 电工技术学报, 2023, 38(8): 2191-2210. Han Xiangyu, Niu Chunping, He Hailong, et al. Review of condition monitoring and intelligent assessment of electromagnetic circuit breaker[J]. Transactions of China Electrotechnical Society, 2023, 38(8): 2191-2210.

[2] 苟军年, 杜愫愫, 刘力. 基于改进掩膜区域卷积神经网络的输电线路绝缘子自爆检测[J]. 电工技术学报, 2023, 38(1): 47-59. Gou Junnian, Du Susu, Liu Li. Transmission line insulator self-explosion detection based on improved mask region-convolutional neural network[J]. Transactions of China Electrotechnical Society, 2023, 38(1): 47-59.

[3] 杨帆, 王梦珺, 谭天, 等. 基于目标像素宽度识别的电力设备红外成像单目测距改进算法[J]. 电工技术学报, 2023, 38(8): 2244-2254. Yang Fan, Wang Mengjun, Tan Tian, et al. An improved monocular ranging method for infrared image of power equipment based on the pixel width recognition of objects[J]. Transactions of China Electrotechnical Society, 2023, 38(8): 2244-2254.

[4] 李斌, 屈璐瑶, 朱新山, 等. 基于多尺度特征融合的绝缘子缺陷检测[J]. 电工技术学报, 2023, 38(1): 60-70. Li Bin, Qu Luyao, Zhu Xinshan, et al. Insulator defect detection based on multi-scale feature fusion[J]. Transactions of China Electrotechnical Society, 2023, 38(1): 60-70.

[5] 普子恒, 张隆, 余欣芸, 等. 500 kV换流变压器无人机巡检路径规划[J]. 电工技术学报, 2023, 38(增刊1): 204-213. Pu Ziheng, Zhang Long, Yu Xinyun, et al. Route planning of unmanned aerial vehicle patrol inspection for 500 kV converter transformer[J]. Transactions of China Electrotechnical Society, 2023, 38(S1): 204-213.

[6] 李浩伟, 张楚岩, 史梓男, 等. 基于红外图像检测和改进YOLOv4的高压套管故障识别方法[J]. 高压电器, 2023, 59(11): 24-31. Li Haowei, Zhang Chuyan, Shi Zinan, et al. Fault identification method of high-voltage bushing based on infrared image detection and improved YOLOv4 algorithm[J]. High Voltage Apparatus, 2023, 59(11): 24-31.

[7] Ma Jiayi, Ma Yong, Li Chang. Infrared and visible image fusion methods and applications: a survey[J]. Information Fusion, 2019, 45: 153-178.

[8] 李云红, 罗雪敏, 苏雪平, 等. 基于改进曲率尺度空间算法的电力设备红外与可见光图像配准[J]. 激光与光电子学进展, 2022, 59(12): 1210010. Li Yunhong, Luo Xuemin, Su Xueping, et al. Registration method for power equipment infrared and visible images based on improved curvature scale space algorithm[J]. Laser & Optoelectronics Progress, 2022, 59(12): 1210010.

[9] 孙浩, 王朋. 一种基于区域划分的改进ORB算法[J]. 北京航空航天大学学报, 2020, 46(9): 1763-1769. Sun Hao, Wang Peng. An improved ORB algorithm based on region division[J]. Journal of Beijing University of Aeronautics and Astronautics, 2020, 46(9): 1763-1769.

[10] 唐泽恬, 丁召, 曾瑞敏, 等. 基于改进的Harris和二次归一化互相关的量子图像拼接算法[J]. 激光与光电子学进展, 2020, 57(10): 101005. Tang Zetian, Ding Zhao, Zeng Ruimin, et al. Quantum image stitching algorithm based on improved Harris and quadratic normalized cross correlation[J]. Laser & Optoelectronics Progress, 2020, 57(10): 101005.

[11] Sedaghat A, Mokhtarzade M, Ebadi H. Uniform robust scale-invariant feature matching for optical remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2011, 49(11): 4516-4527.

[12] Bay H, Ess A, Tuytelaars T, et al. Speeded-up robust features (SURF)[J]. Computer Vision and Image Understanding, 2008, 110(3): 346-359.

[13] Chen Jian, Tian Jie, Lee N, et al. A partial intensity invariant feature descriptor for multimodal retinal image registration[J]. IEEE Transactions on Bio-Medical Engineering, 2010, 57(7): 1707-1718.

[14] Li Ning, Li Yuxuan, Jiao Jichao. Multimodal remote sensing image registration based on adaptive multi-scale PIIFD[J/OL]. Multimedia Tools and Applications, 2024: 1-13[2024-05-16]. https://doi. org/10.1007/ s11042-024-18756-1.

[15] Sun Wanfeng, Gao Haibo, Li Cheng. A two-stage registration strategy for thermal–visible images in substations[J]. Applied Sciences, 2024, 14(3): 1158.

[16] 朱英宏, 李俊山, 汤雨. 基于CSS角点提取的红外与可见光图像匹配算法[J]. 系统工程与电子技术, 2011, 33(11): 2540-2545. Zhu Yinghong, Li Junshan, Tang Yu. Matching algorithm for IR/visible images based on CSS corner extraction[J]. Systems Engineering and Electronics, 2011, 33(11): 2540-2545.

[17] 姜骞, 刘亚东, 方健, 等. 基于轮廓特征的电力设备红外和可见光图像配准方法[J]. 仪器仪表学报,2020, 41(11): 252-260. Jiang Qian, Liu Yadong, Fang Jian, et al. Registration method for power equipment infrared and visible images based on contour feature[J]. Chinese Journal of Scientific Instrument, 2020, 41(11): 252-260.

[18] Wang Zhengbing, Feng Xugang, Xu Guili, et al. A robust visible and infrared image matching algorithm for power equipment based on phase congruency and scale-invariant feature[J]. Optics and Lasers in Engineering, 2023, 164: 107517.

[19] Aguilera C A, Sappa A D, Toledo R. LGHD: a feature descriptor for matching across non-linear intensity variations[C]//2015 IEEE International Conference on Image Processing (ICIP), Quebec City, QC, Canada, 2015: 178-181.

[20] Li Jiayuan, Hu Qingwu, Ai Mingyao. RIFT: multi-modal image matching based on radiation-variation insensitive feature transform[J]. IEEE Transactions on Image Processing, 2020, 29: 3296-3310.

[21] DeTone D, Malisiewicz T, Rabinovich A. SuperPoint: self-supervised interest point detection and descrip-tion[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), Salt Lake City, UT, USA, 2018: 224-236.

[22] Sarlin P E, DeTone D, Malisiewicz T, et al. SuperGlue: learning feature matching with graph neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Seattle, WA, USA, 2020: 4938-4947.

[23] Shi Yan, Cai Junxiong, Shavit Y, et al. ClusterGNN: cluster-based coarse-to-fine graph neural network for efficient feature matching[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), New Orleans, LA, USA, 2022: 12517-12526.

[24] Zhang Shizheng, Li Baohuan, Zhang Zhifeng, et al. Robust corner finding based on multi-scale K-cosine angle detection[J]. IEEE Access, 2020, 8: 66741-66748.

[25] Zhong Baojiang, Liao Wenhe. Direct curvature scale space: theory and corner detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2007, 29(3): 508-512.

[26] Li Dongqing, Zhong Baojiang, Ma Kaikuang. Multi-scale corner detection based on arithmetic mean curvature[C]//2015 IEEE China Summit and Inter-national Conference on Signal and Information Processing (ChinaSIP), Chengdu, China, 2015: 433-437.

[27] Rosenfeld A, Johnston E. Angle detection on digital curves[J]. IEEE Transactions on Computers, 1973, C-22(9): 875-878.

[28] Wang Zhengbing, Feng Xugang, Li Dan, et al. A robust multi-source image matching method for power equipment based on improved PIIFD[C]//2023 8th International Conference on Signal and Image Processing (ICSIP), Wuxi, China, 2023: 254-258.

[29] Gao Chenzhong, Li Wei. Multi-scale PIIFD for registration of multi-source remote sensing images[J]. Journal of Beijing Institute of Technology, 2021, 30(2): 113-124.

[30] 谭建豪, 殷旺, 刘力铭, 等. 引入全局上下文特征模块的DenseNet孪生网络目标跟踪[J]. 电子与信息学报, 2021, 43(1): 179-186. Tan Jianhao, Yin Wang, Liu Liming, et al. DenseNet-Siamese network with global context feature module for object tracking[J]. Journal of Electronics & Information Technology, 2021, 43(1): 179-186.

[31] Deng Haowen, Birdal T, Ilic S. PPFNet: global context aware local features for robust 3D point matching[C]// 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, 2018: 195-205.

[32] 朱惠玲, 牛哲文, 黄克灿, 等. 基于单阶段目标检测算法的变电设备红外图像目标识别及定位[J]. 电力自动化设备, 2021, 41(8): 217-224. Zhu Huiling, Niu Zhewen, Huang Kecan, et al. Identification and location of infrared image for substation equipment based on single-stage object detection algorithm[J]. Electric Power Automation Equipment, 2021, 41(8): 217-224.

Infrared and Visible Image Matching Method for Power Equipment Based on Local and Global Features

Feng Xugang1,2,3 Ruan Shanhui3 Wang Zhengbing1,2,3 An Shuo3 Zhang Keqi3

(1. Anhui Province Engineering Laboratory of Intelligent Demolition Equipment Anhui University of Technology Maanshan 243032 China 2. Anhui Engineering Research Center for Intelligent Applications and Security of Industrial Internet Anhui University of Technology Maanshan 243032 China 3. School of Electrical and Information Engineering Anhui University of Technology Maanshan 243032 China)

Abstract The most intuitive manifestation of power equipment failure is temperature abnormality, through the fusion of infrared and visible images of power equipment can realize the analysis and detection of equipment operation status. Aiming at the problem that the matching process of infrared and visible images of power equipment is greatly affected by the local intensity difference of the images and the difficulty of feature point description and matching, an infrared and visible image matching method for power equipment based on local and global features is proposed.

First, the infrared and visible images of power equipment undergo preprocessing through grayscale conversion and normalization. The Canny algorithm is then applied to extract prominent contour features. Secondly, a threshold is set to solve the problem of possible misestimation in k-cosine estimation of curvature. Then the feature points in the contour image are detected separately by the multi-scale corner detection algorithm based on arithmetic mean k-cosine curvature. The proposed curvature adaptive weighting-based principal direction assignment method is used to assign feature principal directions to each feature point to achieve scale and rotation invariance. Then the PIIFD and global context descriptor are constructed for each feature point, and the proposed similarity bidirectional matching method is utilized to complete the preliminary matching. Finally, the RANSAC algorithm is used to obtain the final matching results and thus the parameters of the affine transformation model between images.

The experimental results show that the algorithm in this paper successfully matches 10 groups of images, and the average accuracy of the proposed method is 93.41%, and the average repetition rate is 33.56%, which verifies that the matching method in this paper can effectively match the infrared and visible images of power equipment. Compared with PIIFD, LGHD and CAO matching algorithms, the number of correct matching points is significantly increased, the average accuracy is improved by 50.71, 27.62 and 11.11 percentage points compared with the other three algorithms, and the average repetition rate is improved by 27.69, 28.81 and 19.18 percentage points respectively. The accurate matching with visible images can still be realized after scaling and rotating changes to the infrared images respectively.

The contributions of the proposed infrared and visible image matching method for power equipment based on local and global features are as follows: (1) The improved k-cosine curvature can accurately reflect the curvature meaning, and a large number of feature points with high accuracy and scale invariance can be extracted by multi-scale arithmetic mean curvature feature detection. (2) The principal orientation assignment method based on curvature adaptive weighting proposed in this paper is robust when small-angle rotations occur between image pairs. (3) By proposing a feature description method that combines global context information with local feature information, the effect of local intensity differences on the matching results is effectively overcome, and infrared and visible image matching with scale invariance is realized.

Keywords: Power equipment, image matching, infrared and visible images, global context descriptor, feature similarity matching

DOI: 10.19595/j.cnki.1000-6753.tces.240529

中图分类号:TP391.4

安徽省高等学校自然科学研究重点项目(2023AH051107)、安徽省智能破拆装备工程实验室开放基金项目(APELIDE2022A001)、安徽省工业互联网智能应用与安全工程研究中心开放基金项目(IASII22-07)和安徽高校自然科学研究重大项目(KJ2021ZD0042)资助。

收稿日期 2024-04-02

改稿日期 2024-05-16

作者简介

冯旭刚 男,1979年生,教授,硕士生导师,研究方向为流程工业先进检测技术及智能优化控制。E-mail:fxg@ahut.edu.cn

王正兵 男,1989年生,博士,硕士生导师,研究方向为工业视觉检测和图像处理。E-mail:wangzb89@ahut.edu.cn(通信作者)

(编辑 李 冰)

余弦曲率(Arithmetic Mean k-cosine Curvature, AMKC)的多尺度角检测算法,在图像的轮廓特征上提取具有尺度不变性的特征点,并利用特征点局部曲率计算特征点的主方向,提高匹配方法对尺度差异和旋转差异的鲁棒性;然后,分别计算每个特征点的PIIFD和全局上下文特征描述符,充分利用图像的局部特征和全局特征描述图像特征;最后,对两种特征描述符的相似度进行加权融合,利用相似度双向匹配方法和随机抽样一致(Random Sample Consensus, RANSAC)方法获取正确的匹配特征点对,进而得到图像间的仿射变换模型参数。

余弦曲率(Arithmetic Mean k-cosine Curvature, AMKC)的多尺度角检测算法,在图像的轮廓特征上提取具有尺度不变性的特征点,并利用特征点局部曲率计算特征点的主方向,提高匹配方法对尺度差异和旋转差异的鲁棒性;然后,分别计算每个特征点的PIIFD和全局上下文特征描述符,充分利用图像的局部特征和全局特征描述图像特征;最后,对两种特征描述符的相似度进行加权融合,利用相似度双向匹配方法和随机抽样一致(Random Sample Consensus, RANSAC)方法获取正确的匹配特征点对,进而得到图像间的仿射变换模型参数。

(1)

(1)

为边缘轮廓上的点;

为边缘轮廓上的点; 为轮廓点

为轮廓点 个点的曲率为

个点的曲率为 ,判定轮廓点是否为特征点的两个基本标准为:①

,判定轮廓点是否为特征点的两个基本标准为:① 是曲率的局部极大值;②

是曲率的局部极大值;② 。

。

。将点

。将点

(2)

(2)

(3)

(3) (4)

(4) 的大小(即绝对值)应用阈值

的大小(即绝对值)应用阈值 来检测角特征。

来检测角特征。 余弦是常用的度量标准之一,用于计算轮廓曲线的离散曲率。定义一个给定点

余弦是常用的度量标准之一,用于计算轮廓曲线的离散曲率。定义一个给定点 (5)

(5)

(6)

(6) (7)

(7) 和

和 分别为点

分别为点 为向量

为向量 ,但是实际点

,但是实际点 。

。 (8)

(8) 、

、 、

、 ,在展现较好性能的同时也没有加重计算负担,整体均衡性最好。3个尺度下的算术平均k余弦曲率计算示意图如图2所示。本文多尺度角检测中尺度的含义为计算轮廓点的

,在展现较好性能的同时也没有加重计算负担,整体均衡性最好。3个尺度下的算术平均k余弦曲率计算示意图如图2所示。本文多尺度角检测中尺度的含义为计算轮廓点的

是在轮廓曲线Γ上检测到的一个特征点,为了确定特征点

是在轮廓曲线Γ上检测到的一个特征点,为了确定特征点 和

和 形成的合成向量,表示为

形成的合成向量,表示为 (9)

(9)

(10)

(10) (11)

(11) 的点;

的点; 、

、 和

和 分别为轮廓上点

分别为轮廓上点 为尺度

为尺度 (12)

(12) 为特征点

为特征点 累积为

累积为 (13)

(13)

的方向作为特征点

的方向作为特征点 (14)

(14)

(15)

(15)

为单个子区间的方向直方图。由于异源图像中对应特征点的主方向可能是相反的,需进一步采用矩阵线性组合法解决这一问题。设矩阵Q为将矩阵H旋转180°后得到的结果,则PIIFD定义为

为单个子区间的方向直方图。由于异源图像中对应特征点的主方向可能是相反的,需进一步采用矩阵线性组合法解决这一问题。设矩阵Q为将矩阵H旋转180°后得到的结果,则PIIFD定义为 (16)

(16) 和

和 分别为矩阵H和Q的第i行;r为调节参数。

分别为矩阵H和Q的第i行;r为调节参数。 ,选定与

,选定与 。其中,t = λm,m为图像中检测到的所有特征点的个数,λ为平衡参数,本文中取值为0.7。

。其中,t = λm,m为图像中检测到的所有特征点的个数,λ为平衡参数,本文中取值为0.7。

与特征点

与特征点 主方向和特征点

主方向和特征点 表示,因此特征点的全局上下文描述可以表示为

表示,因此特征点的全局上下文描述可以表示为 (17)

(17)

进一步化简为直方图,描述为

进一步化简为直方图,描述为 (18)

(18) 为特征点

为特征点 (19)

(19)

和

和 为两个特征点的特征描述符。将两个特征点的PIIFD代入式(19)可得局部相似度,记为

为两个特征点的特征描述符。将两个特征点的PIIFD代入式(19)可得局部相似度,记为 ;将其全局上下文特征描述符代入式(19)可得全局相似度,记为

;将其全局上下文特征描述符代入式(19)可得全局相似度,记为 ,则该特征点对之间的相似度可定义为

,则该特征点对之间的相似度可定义为 (20)

(20) =0.7。

=0.7。 和

和 是从图像中提取的特征点集合,前者来源于参考图像,后者来源于待匹配图像。根据式(19)所定义的相似度,可以构建两组特征点的初始对应关系。本文算法确定两幅图像中的最佳匹配点对采用的策略是双向匹配,只有当点

是从图像中提取的特征点集合,前者来源于参考图像,后者来源于待匹配图像。根据式(19)所定义的相似度,可以构建两组特征点的初始对应关系。本文算法确定两幅图像中的最佳匹配点对采用的策略是双向匹配,只有当点 在参考图像中与点

在参考图像中与点 的相似度最高,同时点

的相似度最高,同时点

(21)

(21) (22)

(22)

(23)

(23) 为可见光图像中提取的特征点数量;

为可见光图像中提取的特征点数量; 为红外图像中提取的特征点数量。

为红外图像中提取的特征点数量。

余弦曲率可以准确地反映曲率含义,通过多尺度算术平均曲率特征检测,可以提取大量精度高且具有尺度不变性的特征点;而利用多尺度曲率信息分配特征点主方向,具有一定的旋转不变性;通过提出全局上下文信息结合局部特征信息的特征描述方法,有效地消除了局部灰度差异对匹配结果的影响,实现了具有尺度不变性的红外和可见光图像匹配。所提方法的平均准确率为93.41%,平均重复率为33.56%,验证了本文匹配方法能够有效地匹配电力设备红外和可见光图像。

余弦曲率可以准确地反映曲率含义,通过多尺度算术平均曲率特征检测,可以提取大量精度高且具有尺度不变性的特征点;而利用多尺度曲率信息分配特征点主方向,具有一定的旋转不变性;通过提出全局上下文信息结合局部特征信息的特征描述方法,有效地消除了局部灰度差异对匹配结果的影响,实现了具有尺度不变性的红外和可见光图像匹配。所提方法的平均准确率为93.41%,平均重复率为33.56%,验证了本文匹配方法能够有效地匹配电力设备红外和可见光图像。