0 引言

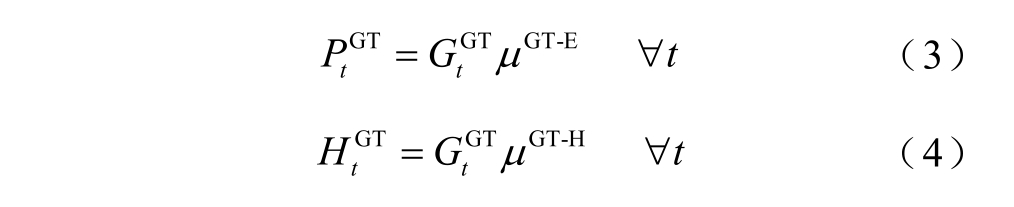

面向国家“30·60”双碳目标,如何深化能源系统变革发展、提升能源系统运行效益与新能源利用水平是当前研究的重点[1-2]。综合能源系统通过汇集电力、热力、燃气等多种异质能源,实现不同类型能源之间的相互耦合及转换利用,有效提升能源系统中异质能源的利用效率与新能源消纳能力[3-5]。

作为综合能源系统典型场景,园区综合能源系统(Park Integrated Energy System,PIES)聚合电、热、气等多种能源负荷需求[6-7],通过滚动制定系统管理方案来动态调整其能源采购、转换及存储行为,满足多能负荷用能需求并提升其新能源消纳能力。然而,PIES 不同系统的管理时间尺度差异性、新能源机组与多能负荷的不确定性,以及PIES 自身复杂的能源转换关系都增加了其制定管理方案、优化经济效益的难度[8-10]。

目前,部分研究工作采用多时间尺度优化模型来提升综合能源系统(Integrated Energy System,IES)能源耦合能力与经济效益[11-15]。文献[12]提出了一种包含三个阶段(日前、日内、实时)的IES 多时间尺度调度优化方法,并采用分布式模型控制预测(Distributed Model Prediction Control,DMPC)方法提升新能源出力与负荷不确定性的预测精度;文献[13]在日内与实时两个时间尺度上,分别采用场景分析法、基于模型预测控制法提升系统稳定性,平抑由预测误差带来的系统功率波动;文献[14]面向电能与热能、气能的响应时间尺度差异,在三个时间尺度上建立不同能源系统的日内分时间尺度滚动优化模型;文献[15]提出一种IES 运营商双边博弈机制来制定系统日前能源采购方案,并面向冷能、热能设备与电力设备在日内管理时间尺度上的差异性设计一种动态调整模型。现有多时间尺度优化研究工作主要关注于系统耦合结构及多时间尺度管理模型构建,尽管多时间尺度优化模型能够有效克服不同系统的管理时间尺度差异性,但是其管理水平依赖并受限于系统的新能源出力与负荷预测精度[16-17]。同时,随着IES/PIES 能源设备种类及耦合结构越发多样,现有研究采用商业求解器的求解时延变得不可忽略,且不同要素的预测误差会不断耦合和累积并最终影响综合能源系统的优化管理效果。因此,现有的多时间尺度优化方法难以满足未来PIES 动态管理需求[18-20]。

此外,部分研究工作利用深度强化学习(Deep Reinforcement Learning,DRL)算法构建IES/PIES智能体管理模型,通过智能体与系统环境交互获取“管理知识”和训练智能体,最终实现动态制定IES/PIES 管理方案的目标[21-26]。杨挺等采用深度策略性梯度(Deep Deterministic Policy Gradient,DDPG)算法来动态调度电、热、气综合能源系统[21];Yang Ting 等在DDPG 算法基础上改进其经验回放机制与正则化方法,优化算法可靠性并提高计算效率[22];文献[23]提出一种DQN(deep Q-learning network)+MILP(mixed-integer linear programming)双层管理模型,有效地降低了深度强化学习模型的训练信息量;为提升深度强化学习模型求解成功率,Xu Zhengwei 等[24]提出一种基于差分进化的DQN算法来提升IES 储能利用率与经济效益。深度强化学习模型具有不依赖针对新能源出力、多能负荷等不确定要素进行精准预测的优势。同时,现有工作验证了深度强化学习模型具有卓越的感知学习与自适应决策能力。然而,由于PIES 汇集了电、热、气等多种能源的存储、转换设备,控制对象的增多使得深度强化学习模型在训练中容易出现不收敛、过收敛等“维数灾难”问题[27-28]。此外,深度强化学习模型的基本模式是通过智能体执行特定动作及环境状态转移实现的。这一模式要求智能体每次执行的动作具有相同的维数[29]。因此,深度强化学习模型难以克服实际情况下PIES 不同能源设备的管理时间尺度差异性。

综上所述,本文面向PIES 经济效益优化需求,考虑DRL 控制对象数量与时间尺度差异性造成的模型训练困难问题,提出一种基于双层DDPG 的PIES 多时间尺度优化管理方法(Multi-time-scale Management-optimized Method for PIES based on bilayer DDPG,MMoMPbD)。该方法以包含电力、热力、燃气三种能源的园区综合能源系统为研究对象,针对不同能源系统的管理时间尺度差异性构建上下两层基于DDPG 算法的管理模型。其中,上层DDPG管理模型以0.5h 为长时间尺度、下层DDPG 管理模型以5min 为短时间尺度和基础时隙长度,滚动制定PIES 内不同系统管理方案,动态调整系统能源 购买、转换与存储行为以维持不同能源系统供需平衡和优化PIES 经济效益。仿真表明,MMoMPbD 方法可实现不同能源系统的多时间尺度管理,并能在避免DRL 出现“维数灾难”情况下提升PIES 的经济效益。

1 园区综合能源系统模型

1.1 园区综合能源系统模型结构

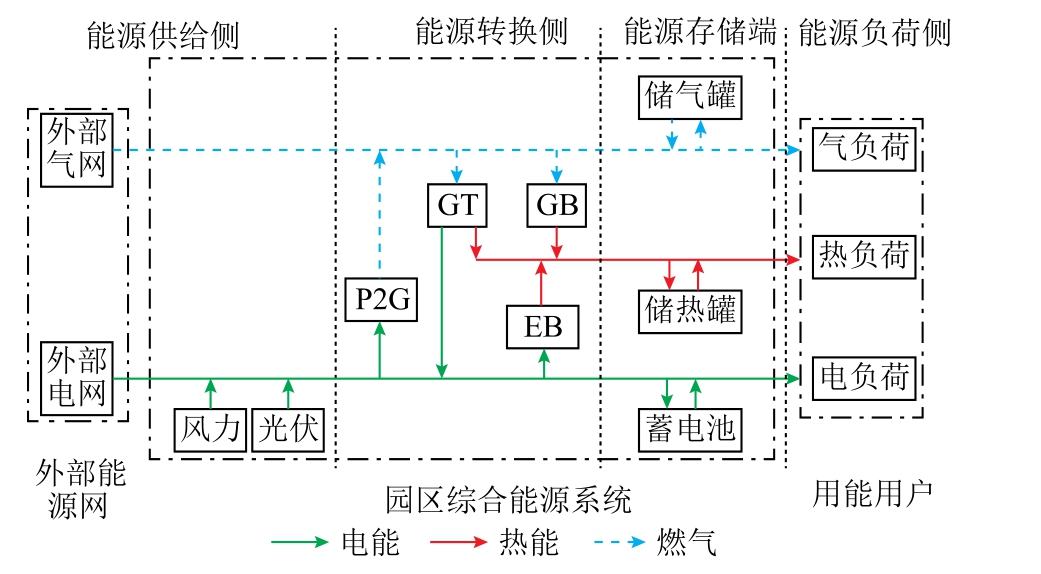

包含电力、热力、燃气三种能源的园区综合能源系统模型结构如图1 所示。PIES 负责在外部能源网与用能负荷间进行能源传输、转换及存储。横向上,PIES 根据能源类型可划分为电力、热力、燃气三个子系统;纵向上,PIES 可划分为能源供给侧、能源转换侧、能源存储端及能源负荷侧四个部分。

图1 园区综合能源系统模型结构

Fig.1 The illustration of the structure of PIES

能源供给侧除了外部电网、气网,还包括具有不确定性的光伏与风力机组;能源转换侧负责进行三种能源耦合转换,其中电转气(Power to Gas,P2G)、电热锅炉(Electric Boiler,EB)设备[30]分别将电能转换为燃气与热能,燃气轮机(Gas Turbine,GT)、燃气锅炉(Gas Boiler,GB)设备分别将燃气转换为电能与热能;能源存储端包含蓄电池、储热罐与储气罐三种设备,通过三种能源的动态存储/释放满足多能负荷的用能需求;能源负荷侧将PIES 用能用户分别聚合并统一表征为电负荷、热负荷及气负荷。

1.2 园区综合能源系统模型结构

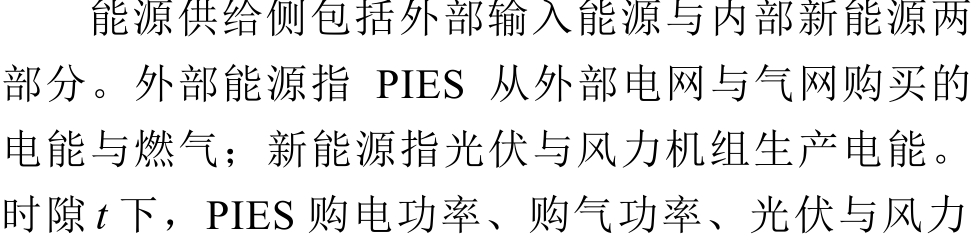

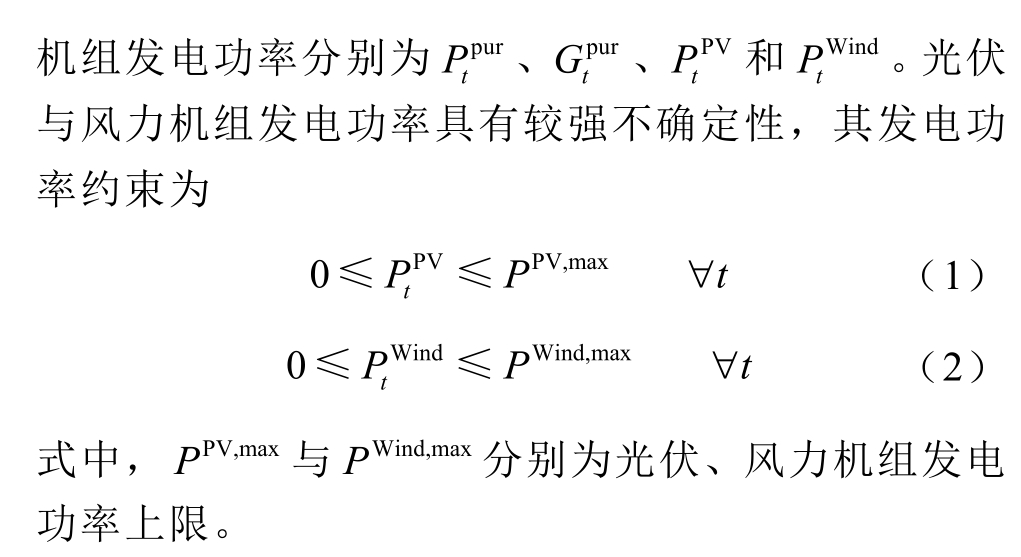

1.2.1 能源供给侧

1.2.2 能源转换侧

能源转换侧利用GT、GB、P2G 及EB 四种设备进行电能、热能与燃气的相互耦合转换。GT 通过燃烧燃气来生产热能与电能。时隙t 下GT 发电功率与产热功率分别为

式中,![]() 为GT 燃气消耗等效功率;μGT-E与μGT-H分别为GT 燃气消耗等效功率与其电能、热能生产功率之间的转换效率[31]。

为GT 燃气消耗等效功率;μGT-E与μGT-H分别为GT 燃气消耗等效功率与其电能、热能生产功率之间的转换效率[31]。

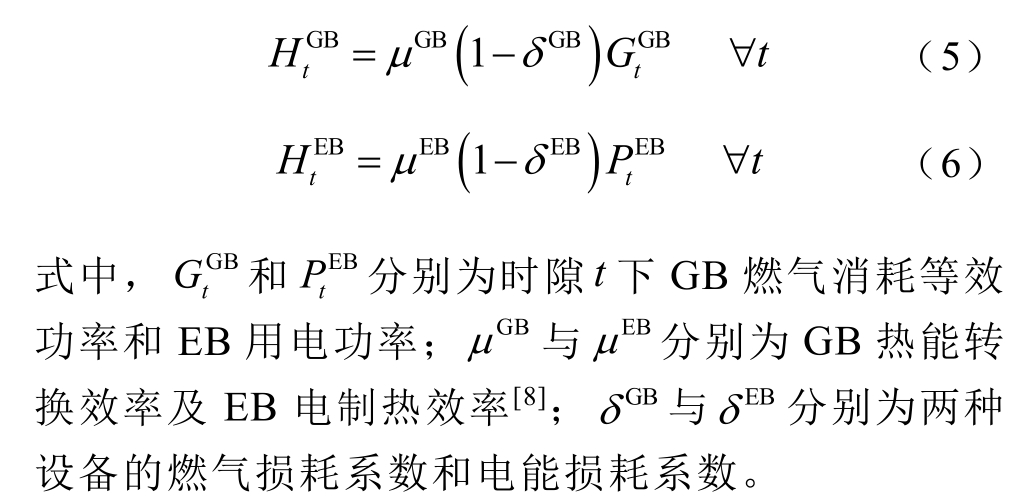

GB 和EB 分别通过消耗燃气和电能来生产热能,两种设备在时隙t 下的产热功率分别为

P2G 利用电能制备燃气,实现多余电能消耗与燃气供给补充。P2G 燃气制备等效功率为

式中,![]() 为P2G 耗电功率;μ P2G与 δ P2G分别为其电气转换效率及电能损耗系数。

为P2G 耗电功率;μ P2G与 δ P2G分别为其电气转换效率及电能损耗系数。

1.2.3 能源存储端

能源存储端通过配置蓄电池、储热罐及储气罐三种储能设备,动态存储/释放系统电能、热能与燃气。蓄电池负责在电力系统电能供给富余时存储电能和存在用电缺口时释放电能。蓄电池荷电状态(State of Charge,SOC)定义式及时序转移关系为

1.2.4 能源负荷侧

PIES 利用所购买、转换及储存能源满足其多能负荷。时隙t 下,PIES 根据能源类型将各个用户分别聚合为电负荷![]() 三类,并且三种负荷大小具有时序不确定性。

三类,并且三种负荷大小具有时序不确定性。

2 基于深度确定性策略梯度算法的PIES管理模型

对于PIES 中任意能源系统而言,其能源购买、转换、存储行为可以表述为一个时序马尔可夫决策过程(Markov Decision Process,MDP),即能源系统针对特定的负荷大小、能源购买价格信号、可再生能源出力以及储能状态,执行特定的能源购买、转换及存储动作,并进而转换到新的系统储能与供需状态下。深度强化学习算法凭借其较强的环境感知与学习能力,以及无须针对负荷、新能源出力等不确定性要素进行精准预测的优势[32]能够较好地适用于本文问题。鉴于PIES 多能负荷大小、设备运行功率等要素均为连续变量,且转换为离散变量会引起精度损失等问题,因此不宜采用面向离散变量的深度强化学习算法优化PIES 管理[33-34]。

本文采用深度确定性策略梯度(DDPG)算法构建PIES 管理模型,滚动制定各能源系统管理方案。PIES 管理模型的重点在于构建DDPG 智能体,并通过与系统环境开展“交互试错学习”来获取相应管 理“知识”,从而达到训练DDPG 智能体和获取制定系统管理方案的能力[35]。基于DDPG 算法的PIES管理模型架构如图2 所示,DDPG 智能体由主Q 网络 Θ Q、目标Q 网络 Θ Q'、主策略网络 Θ π、目标策略网络 Θ π'以及经验回放池等部分构成[22]。PIES 管理模型的训练过程主要通过迭代执行智能体动作选择与状态转移、知识存储以及网络训练三个步骤来实现,直至达到设定的迭代次数ITE 为止。训练完成的PIES 管理模型即可以在离线模式下承担PIES的实时滚动管理需求。

图2 基于深度确定性策略梯度算法的PIES 管理模型架构

Fig.2 The management model for PIES based on the deep deterministic policy gradient algorithm

(1)DDPG 智能体动作选择与状态转移

针对时隙t,智能体在主策略网络 Θ π中输入当前PIES 环境状态 st,主策略网络 Θ π基于其确定性行为策略π 输出所执行动作 a t。

为确保智能体能够较好地探索环境潜在管理方案及其经济效益,智能体引入探索因子var 控制其动作选择范围,即智能体以 at 为均值、var 为标准差构建正态分布 N (at,var)并从中选定实际动作。

完成动作选择后,智能体利用衰减系数ς 降低探索因子var,防止过拟合情况出现。

(2)DDPG 智能体知识存储

智能体在PIES 环境中执行选定动作 at,PIES环境转移到新的状态 s t+1 并返回给智能体一个相应奖励 rt 。智能体将这一状态转移过程整合成一条“知识”(st ,at ,rt ,s t+1)并存储在经验回放池中。当经验回放池“知识”存储数量超过其容量MemCapacity 后,智能体在每次迭代时随机抽取batch 条“知识”来帮助训练神经网络。

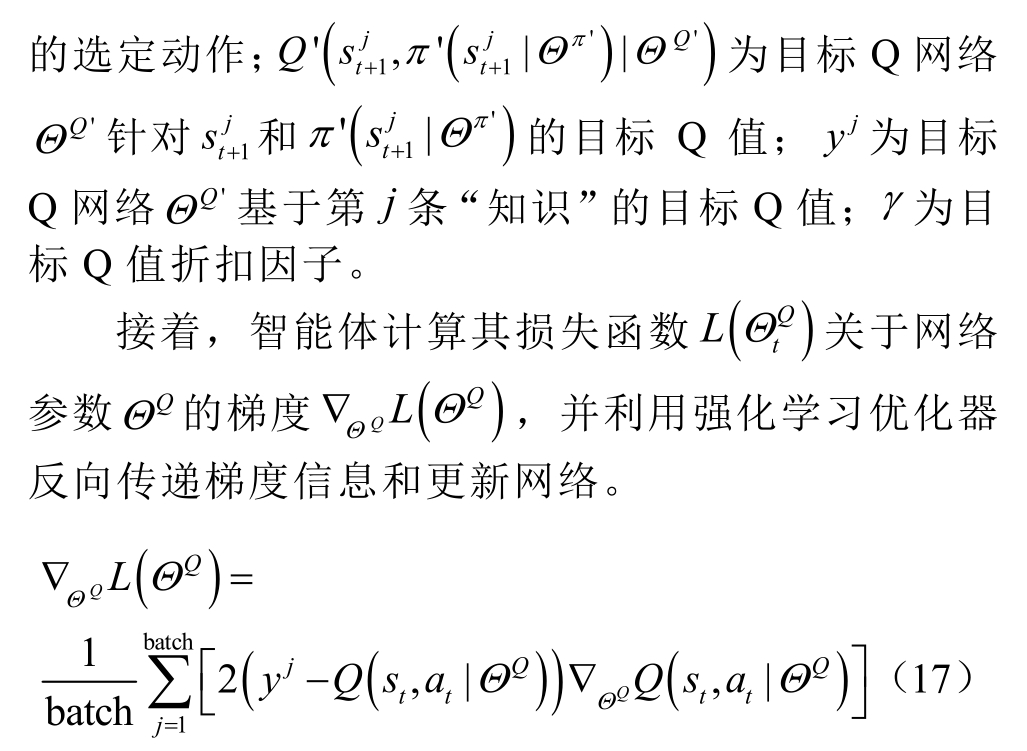

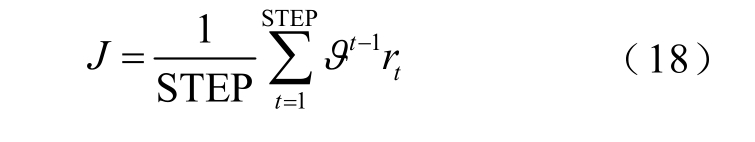

(3)DDPG 智能体网络训练

针对主策略网络 Θ π,智能体首先引入折扣累积奖励函数J 来表征智能体在各状态下均利用该确定性行为策略π 选定动作后所能够累计得到的折扣奖励大小,从而量化评估该策略π 的好坏。

式中,ϑ 为奖励折扣系数;STEP 为一次迭代中的状态转移步数。

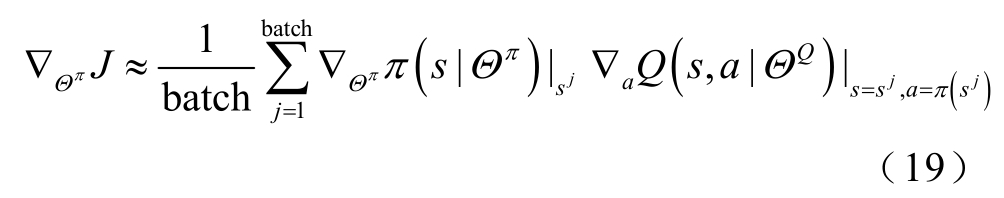

然后,智能体通过计算折扣累积奖励函数J 关于主策略网络 Θ π的梯度来获得策略π 的策略梯度(policy gradient)。同时,智能体结合随机抽取的batch 条“知识”来计算该策略梯度的无偏估计值∇Θ πJ,并利用强化学习优化器反向传递策略梯度信息和更新网络。

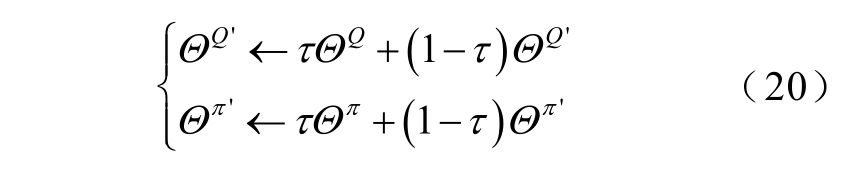

最后,智能体采用软更新方式对目标Q 网络Θ Q'和目标策略网络 Θ π'进行更新,即利用软更新系数τ 控制原有网络参数在每次迭代更新时作为新网络参数的比重。

3 基于双层DDPG 的PIES 多时间尺度优化管理方法(MMoMPbD)

3.1 基于双层DDPG 的PIES 多时间尺度优化管理方法

为克服电力系统与热力、燃气系统在管理时间尺度上的差异性,同时克服由于控制对象增加所引起的管理模型训练“维数灾难”问题,本文以基于DDPG 算法的PIES 管理模型为基础,提出一种基于双层 DDPG 的 PIES 多时间尺度优化管理方法(MMoMPbD),其管理架构示意图如图 3 所示。MMoMPbD 方法的核心思想是分别构建一个上层DDPG 和下层DDPG 管理模型,并分别以0.5h 和5min 为时间尺度滚动制定热力与燃气系统、电力系统管理方案,实现不同能源系统的时间尺度差异化管理。

图3 基于双层DDPG 的PIES 多时间尺度优化管理架构示意图

Fig.3 The illustration of the multi-time-scale optimization management for PIES based on the bi-layer DDPG reinforcement learning

上层DDPG 管理模型(简称上层DDPG)以0.5h为时间尺度,面向上层环境空间时隙t 下的热力与燃气负荷大小、P2G 与EB 运行功率、外部气网价格信号、储热罐与储气罐储能状态,在上层动作空间中制定热力与燃气系统在该长时间尺度下的管理方案。热力与燃气系统管理方案涵盖其在该长时间尺度下的外部购气功率、GT 与GB 运行功率、储热罐储/放热功率及储气罐等效储/放气功率。此外,热力与燃气系统管理方案在该长时间尺度内不会再调整。

下层DDPG 管理模型(简称下层DDPG)以5min为时间尺度及基础时隙长度 Δt,面向下层环境空间时隙t 下的三种负荷大小、光伏与风力机组发电功率、GT 与GB 运行功率、外部电网价格信号、蓄电池荷电状态,在下层动作空间中制定短时间尺度的电力系统管理方案。电力系统管理方案包括其在该短时间尺度(亦是一个基础时隙)下的外部购电功率、P2G 与EB 运行功率、蓄电池充/放电功率。

鉴于上层 DDPG 所制定的热力与燃气系统管理方案在长时间尺度内不会改变,因此其难以克服热力与燃气负荷不确定性。PIES 需利用下层DDPG的短时间尺度灵活性,调整P2G 与EB 运行功率以弥补燃气与热力系统供需缺口。为避免上层DDPG依赖于下层DDPG 进行热能与燃气供给,本文将下层DDPG 在长时间尺度内的P2G 与EB 运行功率累计调整量引入,并作为上层DDPG 奖励函数惩罚项。

总而言之,MMoMPbD 的上、下层DDPG 彼此独立运行却又相互耦合。独立运行指上、下层DDPG 分别考虑热力与燃气系统、电力系统环境来选择动作。相互耦合指上层DDPG 所制定的热力与燃气系统管理方案是下层DDPG 的运行环境;而下层DDPG 在该长时间尺度下的P2G 与EB 运行功率累计调整量反馈为上层DDPG 奖励函数的惩罚项。

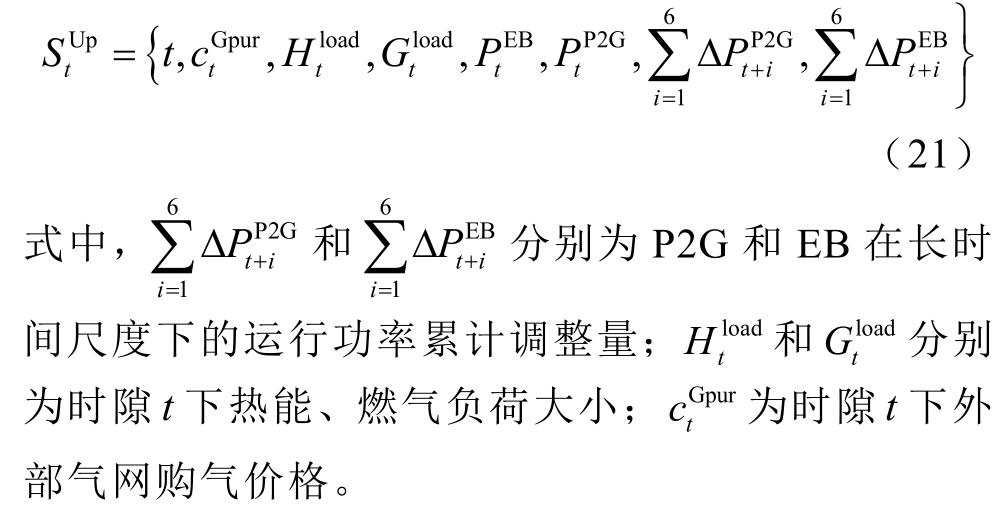

3.2 面向热力与燃气系统的上层DDPG 长时间尺度管理模型

3.2.1 上层DDPG 环境空间

鉴于热力与燃气系统缺乏分钟级调整能力[19],上层DDPG 针对时隙t 下热力与燃气负荷大小、GT与GB 运行功率、外部气网价格信号、储热罐与储气罐储能状态,以0.5h 为时间尺度滚动制定热力与燃气系统管理方案。上层DDPG 环境空间为

3.2.2 上层DDPG 动作空间

上层DDPG 以热力与燃气系统经济效益为优化目标制定管理方案,调整GB 与GT 运行功率、外部购气等效功率、储热罐储/放热功率以及储气罐储/放气等效功率。上层DDPG 动作空间为

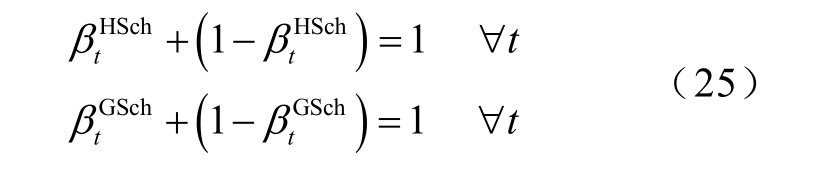

热力与燃气系统管理方案中动作需服从其动作约束。储热罐与储气罐状态约束(即储热罐与储气罐在任意时隙下只能处于储能或放能一种状态)为

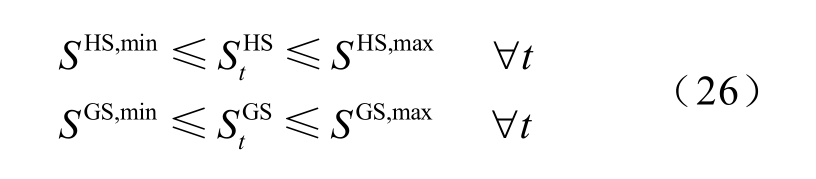

储热罐与储气罐储能状态上、下限约束为

式中,S HS,max 和 S HS,min分别为储热罐最大、最小储能状态;S GS,max和SGS,min分别为储气罐最大、最小储能状态。

储热罐与储气罐功率约束为

式中,H HSch/dis,max和GGSch/dis,max分别为储热罐最大储/放热功率与储气罐最大储/放气等效功率。

外部气网购气动作约束为

式中,G pur,max为外部气网最大输气量的等效功率。

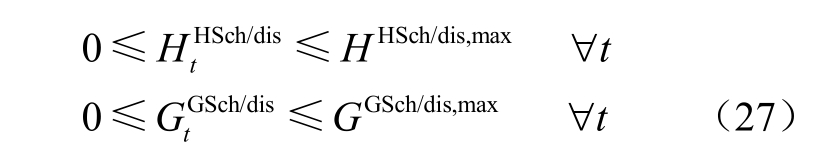

GB 与GT 运行功率约束、爬坡率定义式及爬坡率约束分别为

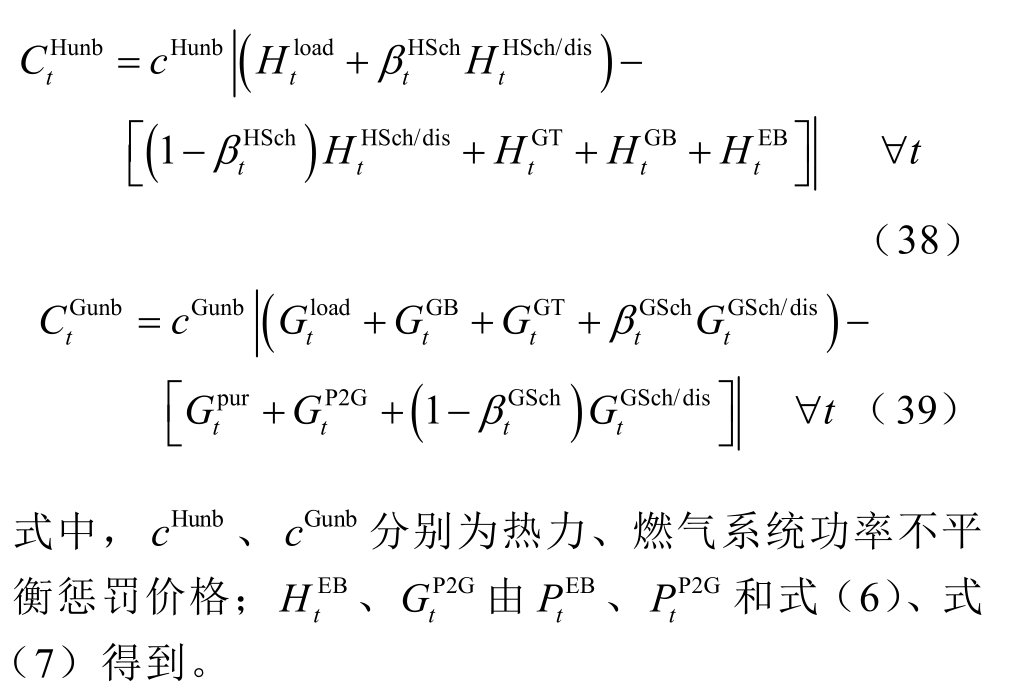

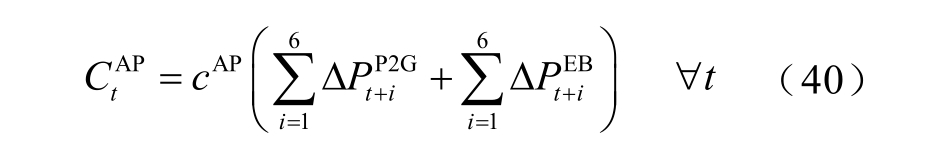

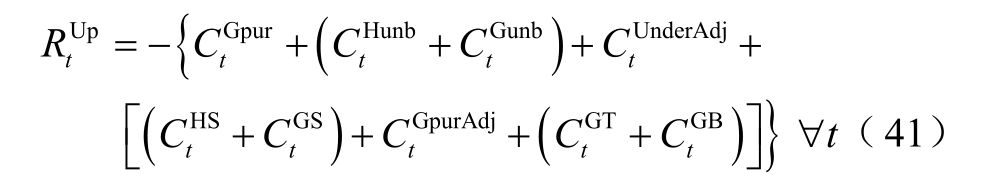

3.2.3 上层DDPG 奖励函数

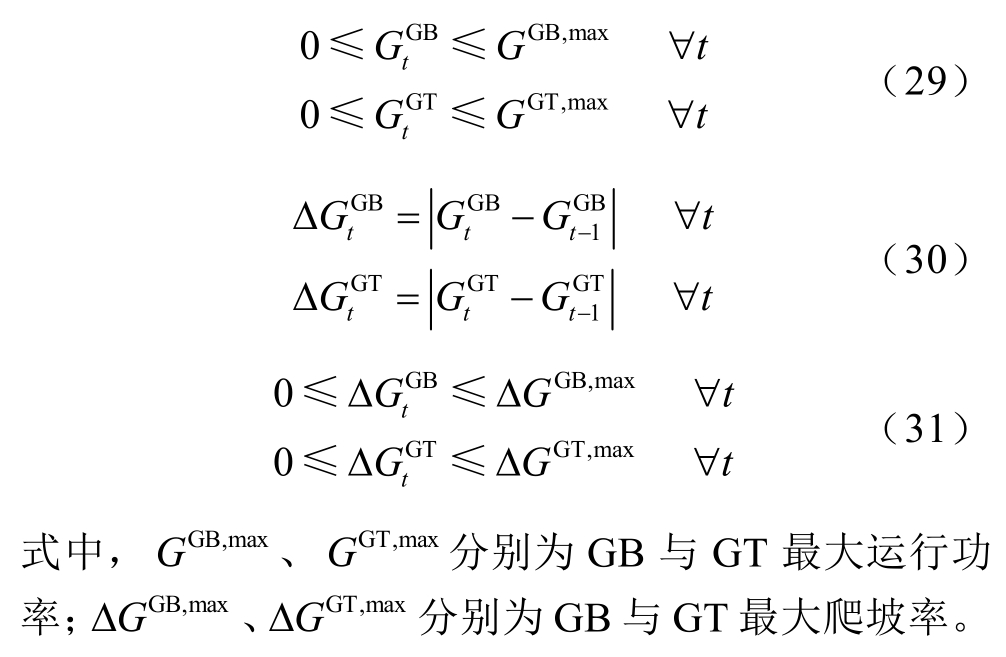

上层DDPG 目标是在长时间尺度内优化热力与燃气系统经济效益,即在尽可能满足热力与燃气负荷用能需求和降低该长时间尺度下P2G 与EB 运行功率累计调整量的同时,降低热力与燃气系统运行成本。热力与燃气系统运行成本包括外部购气成本、外部购气等效功率调控成本、GT 与GB 运行功率调控成本、储热罐与储气罐运行成本,有

式(32)是外部购气成本,![]() 为t +i时隙下外部气网购气价格,GPH和 GHV分别为燃气等效功率与热能转换系数、燃气燃烧高位热值;式(33)是外部购气等效功率调控成本,

为t +i时隙下外部气网购气价格,GPH和 GHV分别为燃气等效功率与热能转换系数、燃气燃烧高位热值;式(33)是外部购气等效功率调控成本,![]() 为外部购气等效功率调控价格;式(34)和式(35)分别是GT 与GB 运行功率调控成本,

为外部购气等效功率调控价格;式(34)和式(35)分别是GT 与GB 运行功率调控成本,![]() 分别为GT 与GB 运行功率调控价格[13];式(36)和式(37)分别是储热罐与储气罐运行成本,c HS、c GS分别为储热罐与储气罐使用寿命单位运行成本, Δt 为单位时隙长度[25]。

分别为GT 与GB 运行功率调控价格[13];式(36)和式(37)分别是储热罐与储气罐运行成本,c HS、c GS分别为储热罐与储气罐使用寿命单位运行成本, Δt 为单位时隙长度[25]。

本文设定外部购气等效功率调控成本、GT 与GB 运行功率调控成本的目的在于:避免在两个连续长时间尺度下过度调整外部购气等效功率、GT 与GB 运行功率,从而避免引起外部气网负荷陡变的情况以及设备运行的潜在风险。

热力与燃气系统的供需不平衡惩罚分别为

如前所述,为避免上层DDPG 依赖下层DDPG调整P2G 与EB 运行功率以供给燃气和热能,本文引入P2G 与EB 设备运行功率累计调整量惩罚项,促使上层DDPG 更加合理地制定热力与燃气系统管理方案。

式中,![]() 分别为P2G 与EB 在长时间尺度下的运行功率累计调整量;c AP为下层DDPG功率累计调整量惩罚价格。

分别为P2G 与EB 在长时间尺度下的运行功率累计调整量;c AP为下层DDPG功率累计调整量惩罚价格。

综上所述,上层DDPG 基于状态![]() 执行动作

执行动作![]() 后获得的奖励函数值为

后获得的奖励函数值为

3.3 面向电力系统的下层DDPG 短时间尺度管理模型

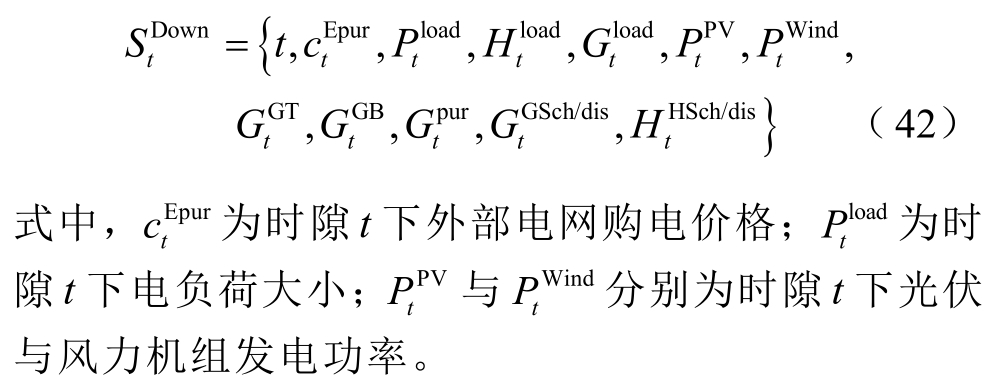

3.3.1 下层DDPG 环境空间

下层DDPG 以5min 为短时间尺度制定电力系统管理方案,通过调整系统外部购电功率、蓄电池充/放电功率来满足电负荷用能需求,同时通过调整P2G 与EB 运行功率以克服热力及燃气负荷在长时间尺度内的不确定性。下层DDPG 环境空间为

3.3.2 下层DDPG 动作空间

下层DDPG 以电力系统经济效益为优化目标滚动制定电力系统管理方案,调整P2G 与EB 运行功率、外部购电功率、蓄电池充/放电功率。下层DDPG动作空间为

式中,![]() 为蓄电池在时隙t 下充/放电功率,即

为蓄电池在时隙t 下充/放电功率,即

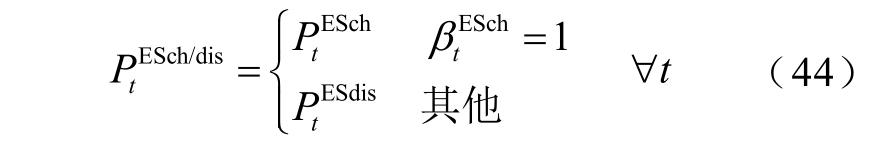

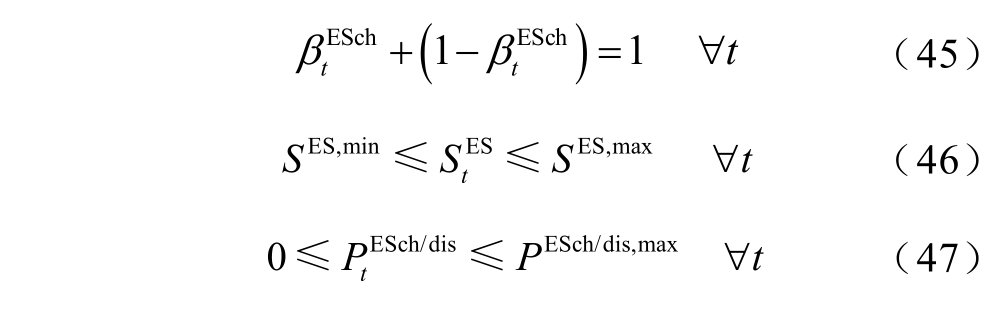

同理,电力系统管理方案中各项动作需服从其动作约束。蓄电池充/放电功率约束为

式(45)是蓄电池状态约束,即蓄电池在任意时隙下只能处于充电或放电一种状态;式(46)是蓄电池荷电状态上下限约束,S ES,max、S ES,min分别为蓄电池最大、最小荷电状态;式(47)是蓄电池充/放电功率约束,P ESch/dis,max为蓄电池最大充/放电功率。

外部电网购电动作约束为

式中,![]() 是外部电网联络线传输功率上限。

是外部电网联络线传输功率上限。

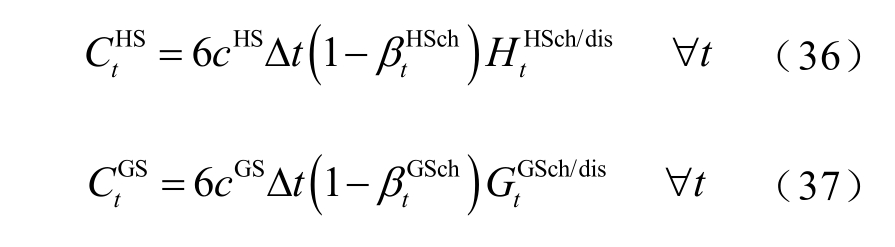

P2G 与EB 运行功率约束、爬坡率定义式及爬坡率约束为

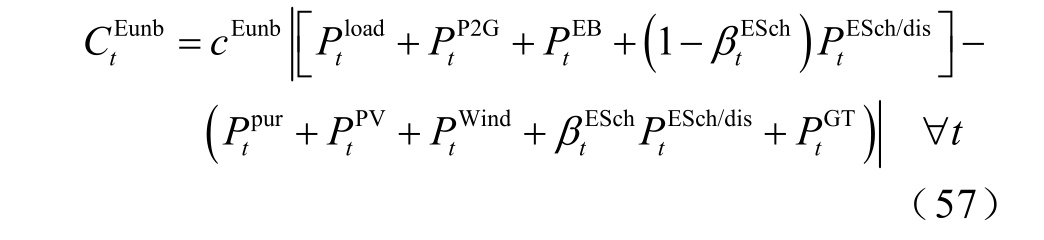

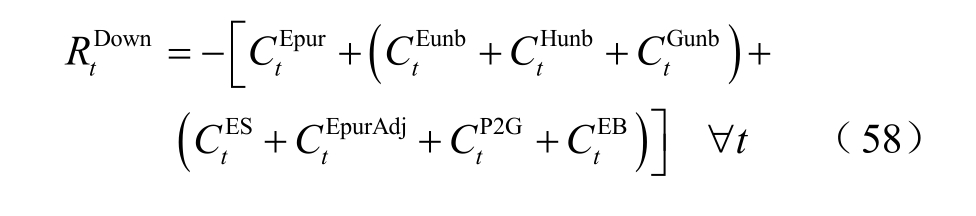

3.3.3 下层DDPG 奖励空间

下层DDPG 目标是在短时间尺度内优化电力系统经济效益,即在尽可能克服三种负荷不确定性同时,降低电力系统运行成本。为此,下层DDPG 需要面向光伏与风力机组发电功率与电负荷不确定性,调整外部购电功率与蓄电池充/放电功率;同时面向热力与燃气负荷不确定性,调整P2G 和EB 运行功率以弥补系统热力与燃气供需缺口。分别为蓄电池不规则充放电过程转换为标准循环使用次数的拟合曲线参数[36]。

下层DDPG 设定购电功率调控成本、P2G 与EB运行功率调控成本的目的在于避免外部购电功率和P2G、EB 运行功率在连续时隙下发生较大变化,从而避免外部电网尖峰负荷、P2G 与EB 设备折损等情况发生。拟合曲线![]() 作用是将蓄电池不规则充放电过程折算成设计使用寿命下的标准充放电过程。

作用是将蓄电池不规则充放电过程折算成设计使用寿命下的标准充放电过程。

针对光伏、风力机组发电功率及电负荷不确定性,电力系统供需不平衡惩罚为

由于弃风弃光行为本质上属于电力系统供需不平衡的一种情况,因此本文不另外设定弃风弃光惩罚项。综上所述,下层DDPG 基于状态![]() 执行动作

执行动作![]() 后获得的奖励函数值为

后获得的奖励函数值为

4 仿真分析

4.1 仿真参数设定

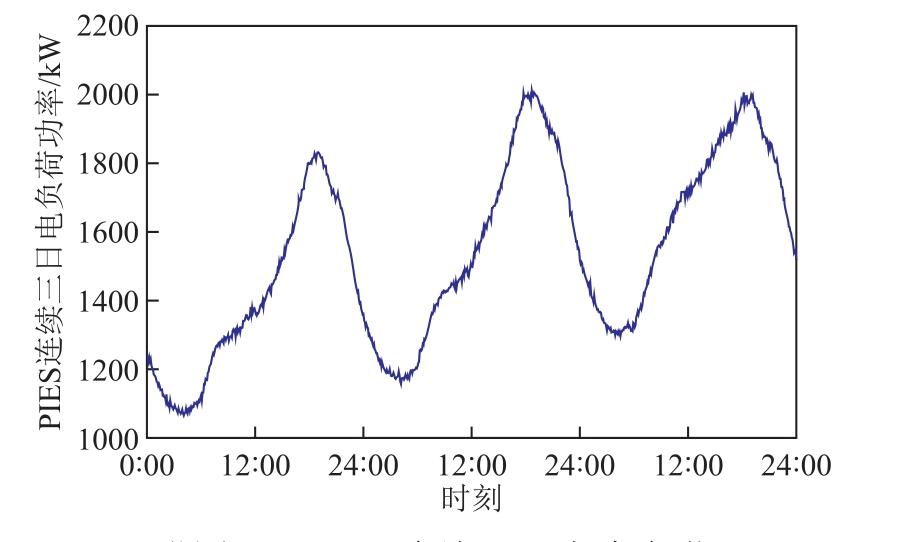

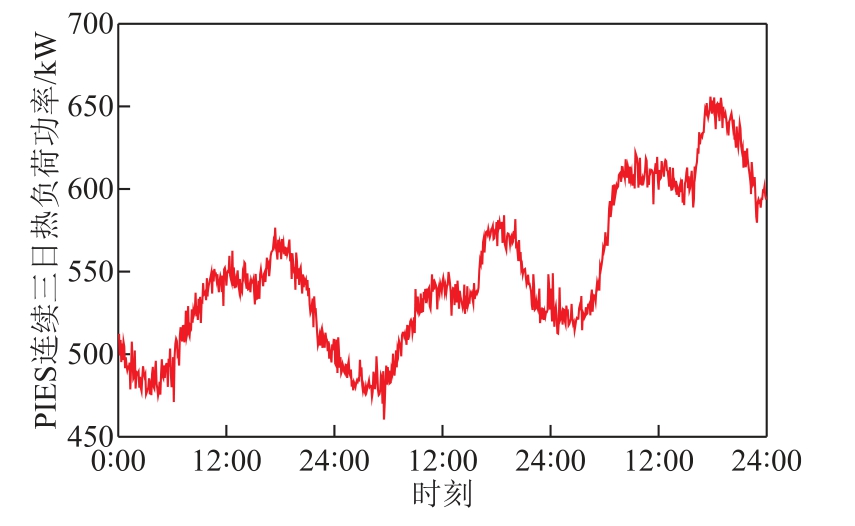

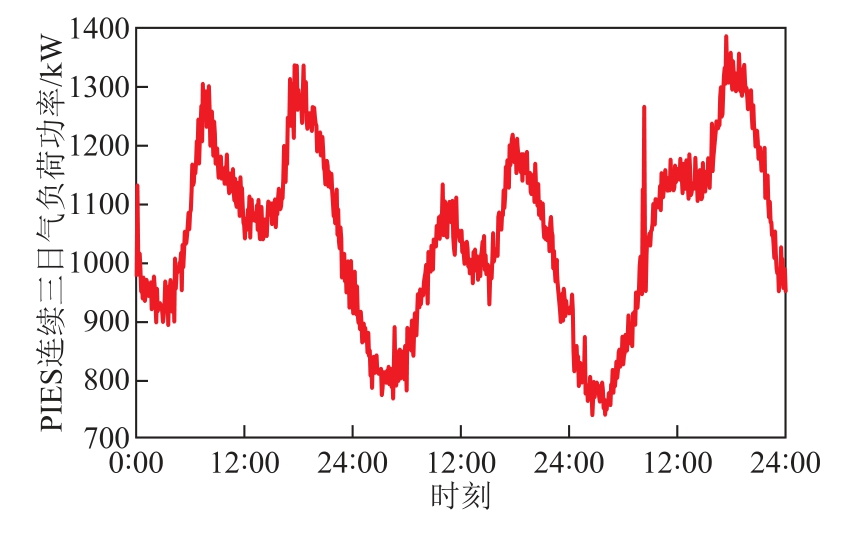

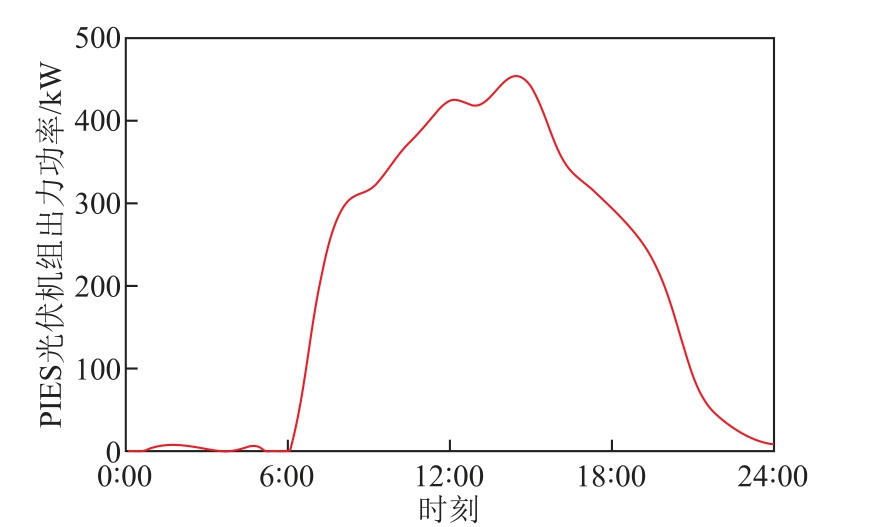

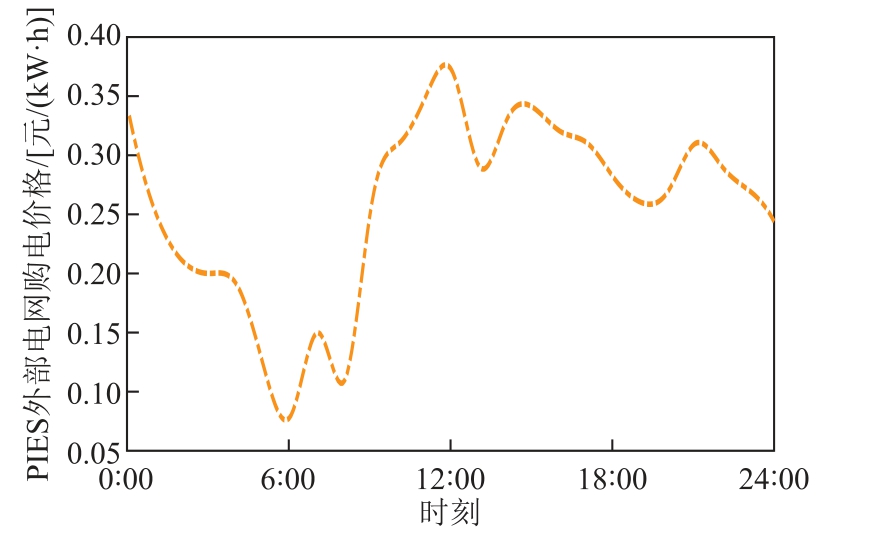

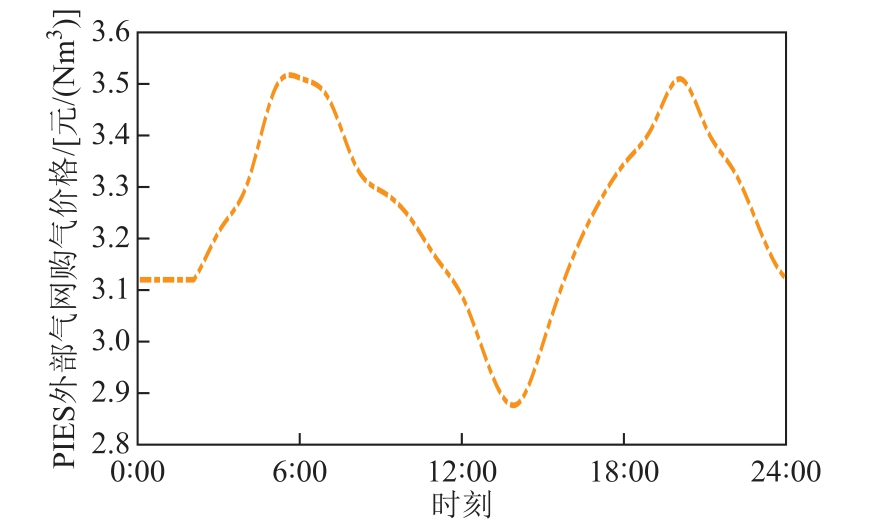

为验证MMoMPbD 方法的有效性,本文以图1所示PIES 模型进行仿真分析。选用德国Amprion 电力公司和Uniper 能源公司在2015 年1 月~3 月间(共计90 天)量测得到的光伏与风力机组出力情况、外部气网与电网价格信号、三种能源负荷大小的历史统计数据作为训练数据集,对上、下层DDPG 管理模型开展训练。训练数据集采样间隔为5min,其中2 月内连续3 日的数据曲线参如附图1~附图7。

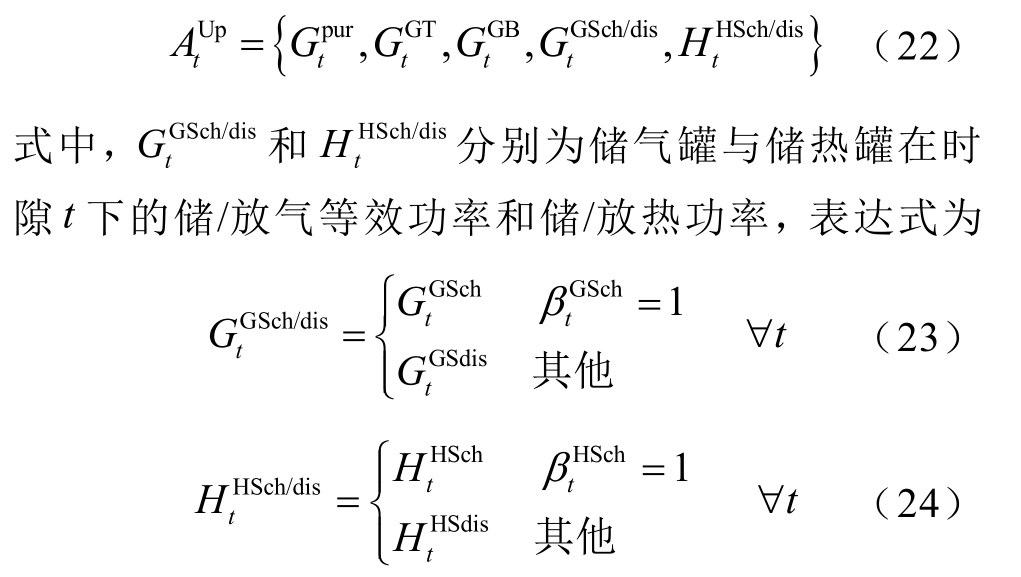

鉴于上、下层DDPG 动作空间的控制对象数量相近(分别为5 个和4 个),因此两个DDPG 管理模型采用相同结构的策略网络、Q 网络及隐藏层激活函数。同时,DDPG 管理模型中主策略网络与目标策略网络相同、主Q 网络与目标Q 网络相同以进行网络软更新。上、下层DDPG 的策略网络与Q 网络结构如图4 所示,其中激活函数分别采用线性修正单元(Rectified Liner Unit,ReLU)和Tanh 函数;策略网络与Q 网络采用的Adam 优化器分别设置0.001 和0.002 的学习率。仿真由一台配置了Inter Core i7-10800 CPU 和8GB 的RAM 计算机完成,软件环境为Python3.8 和Pytorch1.4.0。仿真其他参数设定参见附表1[12-19,22,25]。

图4 DDPG 管理模型策略网络、Q 网络结构

Fig.4 The structure of Actor and Q-networks of management model using DDPG algorithm

4.2 仿真结果分析

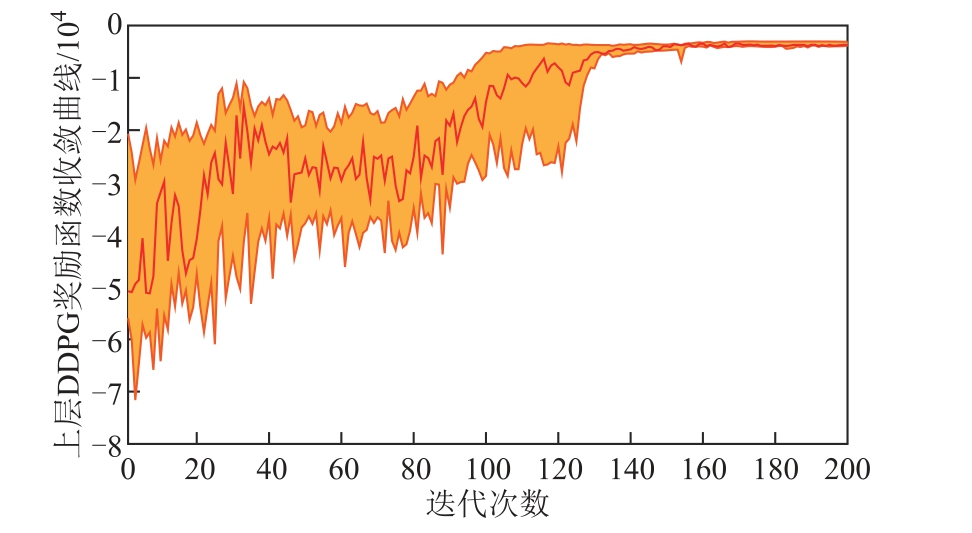

本文首先验证MMoMPbD 方法的有效性。上、下层DDPG 在5 次实验中的平均奖励函数收敛曲线及波动区间分别为图5 与图6 中的加粗实线与阴影 区域。如图5 及图6 所示,上、下层DDPG 奖励函数均在迭代过程中训练收敛,因此上、下层DDPG管理模型能够有效调整热力与燃气系统、电力系统的能源购买、转换与存储行为。

图5 上层DDPG 奖励函数平均收敛曲线及波动区间

Fig.5 The average convergence curve and fluctuation interval of the upper DDPG model’s reward function

图6 下层DDPG 奖励函数平均收敛曲线及波动区间

Fig.6 The average convergence curve and fluctuation interval of the lower DDPG model’s reward function

此外,上、下层DDPG 奖励函数存在耦合“传递效应”,即上层DDPG 奖励函数的收敛迭代数小于下层DDPG(上、下层DDPG 奖励函数的平均收敛迭代数分别为 139 和 162)。原因是将下层DDPG 在长时间尺度内的P2G 与EB 运行功率累计调整量作为上层DDPG 奖励函数惩罚项,反馈并影 响其制定热力与燃气系统管理方案。因此下层DDPG 奖励函数的收敛受到上层DDPG 训练效果(通过所制定的热力与燃气系统管理方案进行传递)的影响。

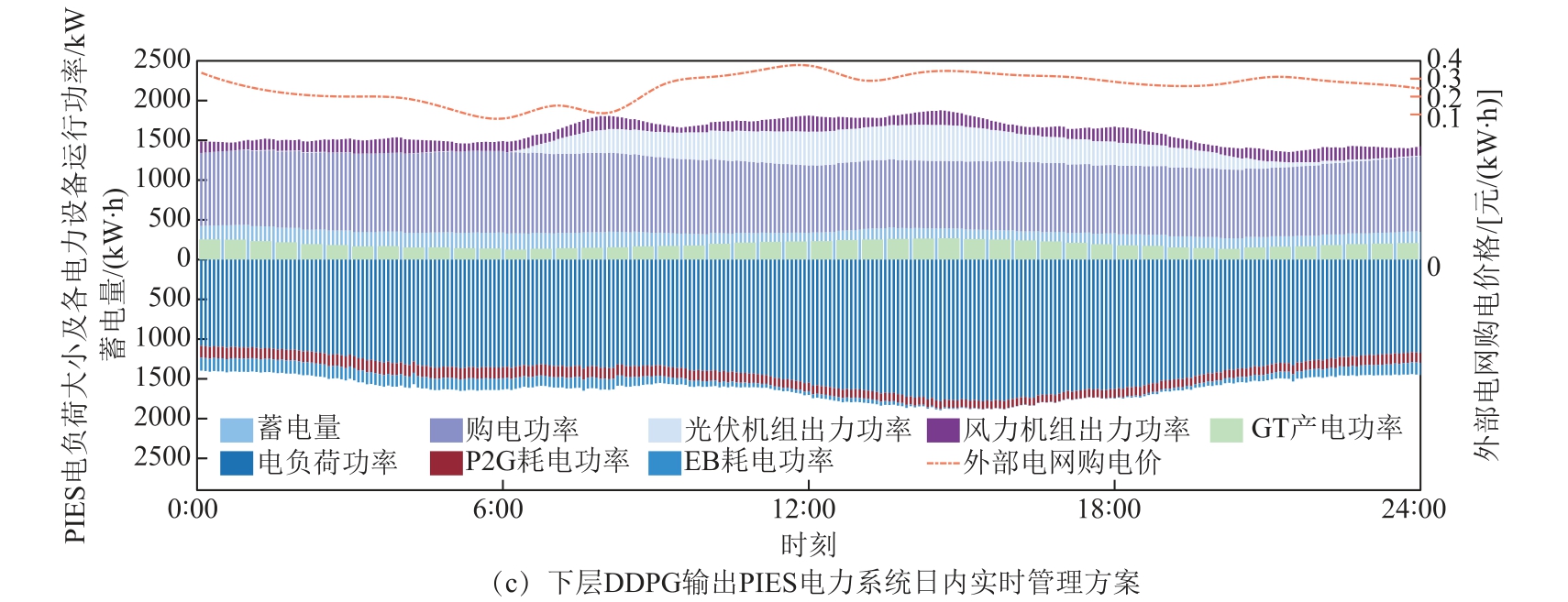

上、下层DDPG 管理模型完成训练后,本文随机选取4 月某日的外部购电价格、购气价格、三种能源负荷大小以及光伏、风机机组出力量测数据,设定为上、下层DDPG 管理模型的实时环境状态(储能状态等其余环境空间由前一时序动作得到),从而得到PIES 电力、热力与燃气系统的日内管理方案。上、下层DDPG 训练完成后,分别以0.5h 为长时间尺度、以5min 为短时间尺度及基础时隙长度,滚动地制定的热力与燃气、电力系统管理方案如图7 所示。除系统储能外,图7 各分图中上、下部分分别是系统能源供给功率总和及需求功率总和的柱状堆积图。

如图7a 所示,在0~6:00 中随着购气价格上升,燃气系统外部购气等效功率逐步减少以降低购气成本;由于燃气供给能力下降,GT 与GB 运行功率相应降低以维持系统供需平衡。如图7b 和图7c 所示,同一时期中,GT 与GB 运行功率下降降低了热力与电力系统的能源供应;鉴于外部电网购电价格在此时期保持低位,电力系统通过提升外部购电功率来维持系统供需平衡。同时在0~12:00 中,电力系统通过运行P2G 与EB 来“填谷”该时期系统电能需求。针对0~12:00GT、GB 及EB 三种设备运行功率波动,热力系统利用储热罐储存多余热能供给,并 在产热量下降时释放储热以满足热负荷需求。

图7 上、下层DDPG 分别输出的PIES 燃气、热力与电力系统日内实时管理方案

Fig.7 The real-time management schemes for the gas,heat,and electricity systems of PIES created by upper and lower DDPG management models

在7:00~14:00 时,外部气网购气价格下降推动燃气系统外部购气等效功率、GT 与GB 运行功率回升;热力系统为平衡该时期GT 与GB 增加的产热,降低了此时期EB 运行功率,并增加了储热罐储热量,同时实现“削峰”电力系统需求量的效果;考虑到此时外部电网购电价格较高,电力系统通过降低购电功率以削减其购能成本,同时实现光伏机组发电消纳;针对风力机组出力不确定性,电力系统通过灵活调节蓄电池蓄电量来动态克服。

在15:00~24:00 时,燃气系统根据外部气网价格信号调整其外部购气功率、GT 与GB 运行功率及储气罐储能状态,动态维持系统供需平衡;在此时期中,电力系统通过增加外部购电功率来弥补光伏、风力机组出力降低所引起的供给缺口;同时,电力系统增加EB 运行功率来提升热能供应量和“填谷”电力系统需求,并通过调节P2G 运行功率与蓄电池蓄电量来分别维持燃气与电力系统供需平衡。

总体上,燃气系统外部购气功率、GT 与GB 运行功率受外部气网价格信号影响较大,其负荷不确定性可通过调节储气量与P2G 运行功率来克服;电力系统外部购电功率受到外部电网价格信号与新能源机组出力的影响,P2G 与EB 有效实现电力负荷“削峰填谷”,并帮助克服长时间尺度下的热力与燃气负荷不确定性;由于热力系统无法直接购买外部热能而依赖其他能源转换供给,其调整灵活性相对较弱、系统供需不平衡更为明显。

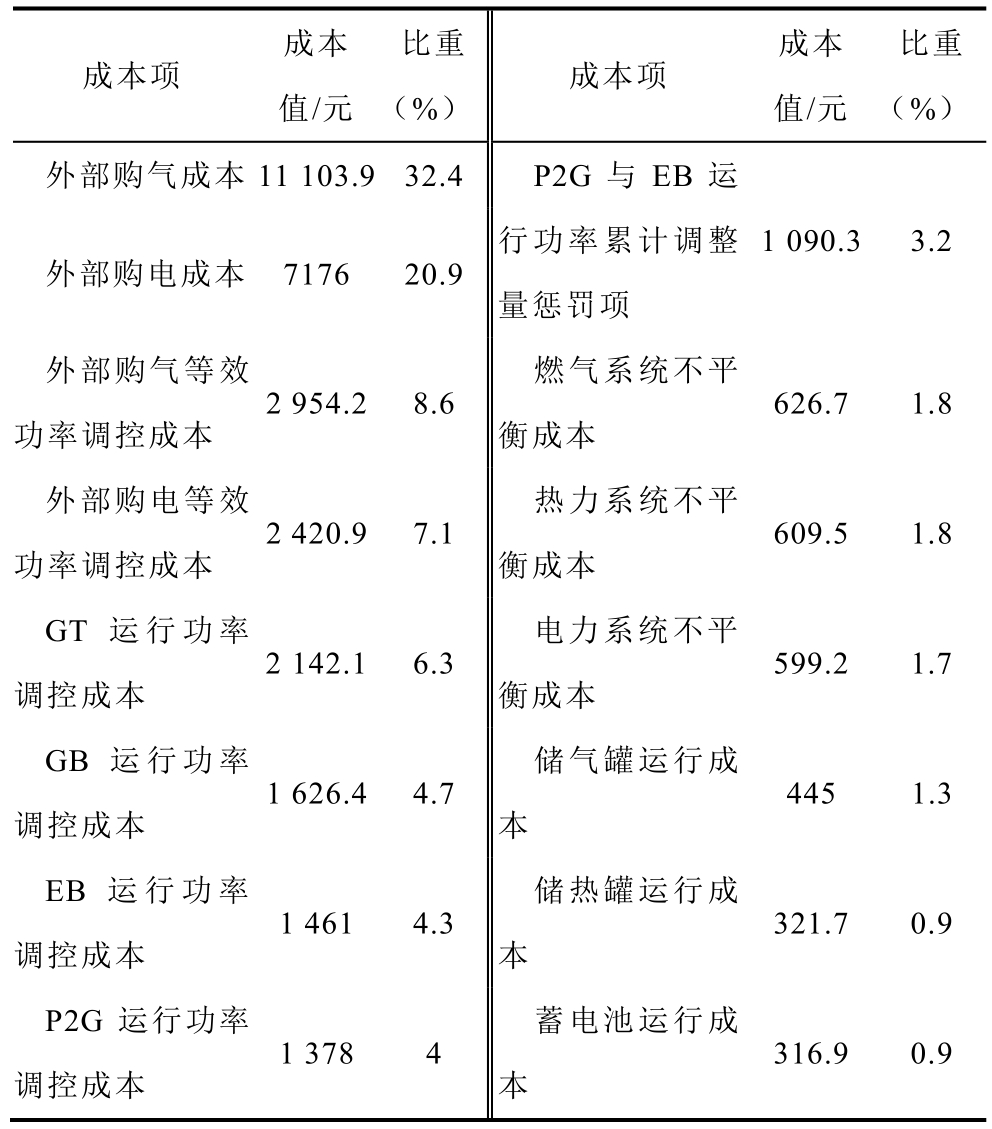

PIES 电力、热力与燃气系统日内管理方案所对应的各部分成本见表1。其中,PIES 的主要成本来自其外部燃气和电能购买行为(分别占比为32.4%和20.9%)。同时,可以注意到,电力系统的不平衡惩罚成本与蓄电池运行成本分别小于燃气与热力系统的不平衡惩罚成本及储能运行成本。这也从侧面证明了电力系统相比于燃气与热力系统(0.5h),能够凭借更小的管理时间尺度(5min),及时和准确地调整储能单元的储能状态(运行成本更小)及设备运行功率(P2G、EB 设备的运行功率调控成本小于GT、GB 设备),克服其系统能量供需不平衡情况。

表1 PIES 燃气、热力与电力系统日内管理方案各 部分成本

Tab.1 The cost structure of the real-time management schemes for PIES’s gas,heat and electricity systems

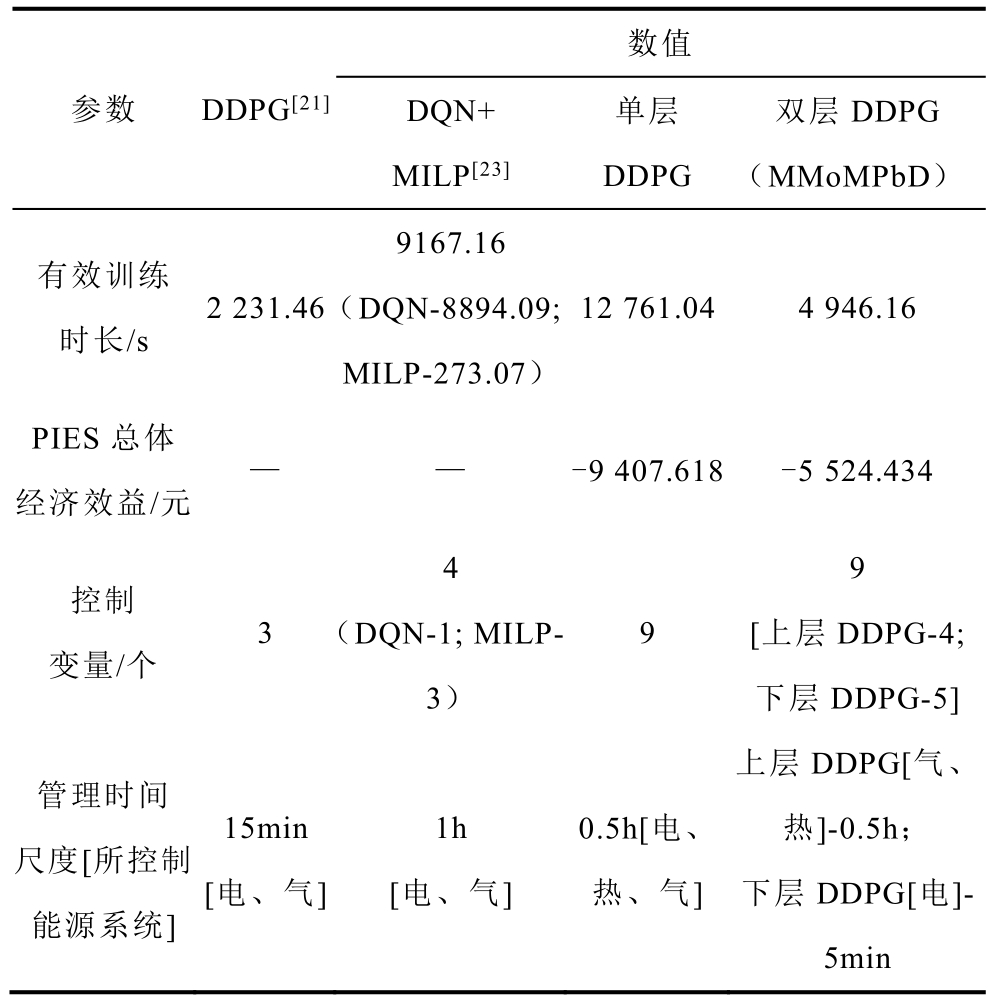

接着,本文对比验证MMoMPbD 方法的综合性能。本文 MMoMPbD 方法与杨挺等提出的基于DDPG 的综合能源系统动态经济调度方法[21]、聂欢欢等提出的基于DQN+MILP 的多能园区系统优化管理机制[23]以及单层DDPG(以0.5h 为时间尺度)优化管理方法,在有效训练时长、PIES 总体经济效益等指标上的仿真性能对比见表2。有效训练时长指利用相同数据集开展30 次实验,不忽略管理模型所出现的不收敛、过拟合等不成功训练情况,统计其成功训练收敛的平均用时。PIES 总体经济效益指管理模型的奖励函数收敛结果,其表征的是三种能源系统效益之和。

表2 算法性能比较

Tab.2 Performance comparison between algorithms

由于文献[23]所设计的综合能源系统模型只考虑电力与热力两种能源系统且未考虑储热设备,文献[21]所设计的园区综合能源系统中燃气仅用于驱动生产热能而未考虑到系统中气负荷用能需求,因此本文所研究的PIES 模型相较两篇文献要更复杂。同时,由于三个综合能源系统模型差异较大、对比模型部分参数缺失且综合能源系统管理时间尺度存在差异性,因此无法统一和准确计算不同深度强化学习管理模型所获得的经济效益。

对比文献[21]与文献[23]发现,DDPG 管理模型相比DQN 管理模型不仅能以更小的时间尺度制定系统管理方案,同时还可以获得更小的有效训练时长。此外,文献[23]通过构建混合整数线性规划模型(MILP)制定综合能源系统的每小时管理方案。由于MILP 在每小时制定系统管理方案时都需要针对热、电负荷与新能源出力进行精准预测并重新计算系统在下一小时的管理方案,因此其相比本文方法需要更大的计算量,并且无法在线制定系统管理方案(日内累计计算时长分别为6 553.68s 和4 946.16s)。同时,通过对比文献[21]与单层DDPG 两种管理模型的有效训练时长和控制变量数指标发现:DDPG管理模型有效训练时长随着其控制变量的增加而快速增加。原因主要是:①DDPG 管理模型的控制变量增加会导致其潜在可行方案呈指数增长,从而对计算机硬件存储与计算能力提出更高要求并进而导致模型训练“维数灾难”;②控制变量增加使得DDPG 管理模型的网络训练与超参数设定更加复杂,进而降低模型训练成功率。

通过对比单层DDPG 与本文MMoMPbD 方法发现:利用多个DDPG 管理模型来划分并管理相同数量的控制变量,能够有效提升DDPG 管理模型的训练成功率与收敛速度,进而降低其有效训练时长。这是因为双层DDPG 通过划分控制变量克服了模型训练“维数灾难”。此外,单层DDPG 受限于系统管理时间尺度(0.5h),难以快速调整三种能源供需情况,进而使得其 PIES 总体经济效益也低于本文MMoMPbD 方法。

总而言之,相比其他三种方法,本文MMoMPbD方法能够在考虑到不同能源系统设备的实际可调控时间尺度、以及不显著增加深度强化学习模型有效训练时长的情况下,提升PIES 的管理运行水平。具体体现在:本文 MMoMPbD 方法不仅能够以更低的时间尺度来灵活管理电力系统设备运行状态(同时考虑到燃气与热力系统的实际管理时间尺度),还能够提升PIES 的可控设备数量。

5 结论

本文研究提出一种基于双层深度强化学习的园区综合能源系统多时间尺度优化管理方法(MMoMPbD)。该方法利用深度确定性策略梯度(DDPG)管理模型滚动制定PIES 能源系统管理方案并优化其经济效益。为克服控制对象数量增加而引起的DDPG 管理模型训练“维数灾难”问题,该方法构建双层DDPG 管理模型,并分别以0.5h 和5min 为时间尺度滚动制定热力与燃气系统、电力系统管理方案。仿真分析验证了本文MMoMPbD 方法能够在两种时间尺度下有效制定三种能源系统的管理方案,提升PIES 总体经济效益和DDPG 管理模型训练性能。本文主要结论如下:

1)本文构建包含电力、热力、燃气三种能源的园区综合能源系统模型,面向异质能源负荷与新能源机组出力不确定性、外部能源价格信号,滚动制定包含能源购买、转换与存储行为的系统管理方案。

2)本文构建基于DDPG 算法的PIES 管理模型,通过制定能源系统管理方案来与环境交互学习,从而获取相应管理“知识”并完成模型训练。

3)本文MMoMPbD 方法分别构建两个DDPG管理模型来承担不同能源系统管理任务,并引入累计调整量惩罚项来实现两层DDPG 相互耦合。该方法解决了实际情况下不同能源系统的管理时间尺度差异性,克服了深度强化学习算法状态转移基本模式与能源系统管理时间尺度差异性之间的矛盾。

此外,仿真结果表明,由于PIES 无法从外部直接购热而依赖于其他能源转换供给热能,在特定情况下(热负荷较大,燃气、电力负荷大/外部购能价格高),可能存在燃气与电力系统不愿提升热能供给并进而引起热力系统出现严重供需不平衡的情况。因此,后续研究需进一步提升PIES 内例如热力等依赖其他能源转换供给的能源系统管理能力,进一步优化PIES 的多能供需平衡能力与经济效益。

附 录

附图1 PIES 连续三日电力负荷

App.Fig.1 Electricity demand for PIES in three days

附图2 PIES 连续三日热力负荷

App.Fig.2 Heat demand for PIES in three days

附图3 PIES 连续三日燃气负荷

App.Fig.3 Gas demand for PIES in three days

附图4 PIES 风力机组发电功率

App.Fig.4 The power of PIES’s wind turbines

附图5 PIES 光伏机组发电功率

App.Fig.5 The power of PIES’s photovoltaic generators

附图6 PIES 外部电网购电价格

App.Fig.6 The electricity price of grids for PIES

附表1 仿真其他参数设定

App.Tab.1 The setting of other simulation parameters

附图7 PIES 外部气网购气价格

App.Fig.7 The gas price of gas networks for PIES

[1]孙伟卿,刘唯,张婕.高比例可再生能源背景下配电网动态重构与移动储能协同优化[J].电力系统自动化,2021,45(19): 80-90.Sun Weiqing,Liu Wei,Zhang Jie.Collaborative optimization for dynamic reconfiguration of distribution network and mobile energy storage in background of high proportion of renewable energy[J].Automation of Electric Power Systems,2021,45(19): 80-90.

[2]施泉生,丁建勇,刘坤,等.含电、气、热3 种储能的微网综合能源系统经济优化运行[J].电力自动化设备,2019,39(8): 269-276,293.Shi Quansheng,Ding Jianyong,Liu Kun,et al.Economic optimal operation of microgrid integrated energy system with electricity,gas and heat storage[J].Electric Power Automation Equipment,2019,39(8): 269-276,293.

[3]Demirhan C D,Tso W W,Powell J B,et al.A multiscale energy systems engineering approach towards integrated multi-product network optimization[J].Applied Energy,2021,281: 116020.

[4]王雪纯,陈红坤,陈磊.提升区域综合能源系统运行灵活性的多主体互动决策模型[J].电工技术学报,2021,36(11): 2207-2219.Wang Xuechun,Chen Hongkun,Chen Lei.Multiplayer interactive decision-making model for operational flexibility improvement of regional integrated energy system[J].Transactions of China Electrotechnical Society,2021,36(11): 2207-2219.

[5]张雨曼,刘学智,严正,等.光伏-储能-热电联产综合能源系统分解协调优化运行研究[J].电工技术学报,2020,35(11): 2372-2386.Zhang Yuman,Liu Xuezhi,Yan Zheng,et al.Decomposition-Coordination based optimization for PV-BESS-CHP integrated energy system[J].Transactions of China Electrotechnical Society,2020,35(11): 2372-2386.

[6]陈昌铭,张群,黄亦昕,等.考虑最优建设时序和云储能的园区综合能源系统优化配置方法[J].电力系统自动化,2022,46(2): 24-32.Chen Changming,Zhang Qun,Huang Yixin,et al.Optimal configuration method of park-level integrated energy system considering optimal construction time sequence and cloud energy storage[J].Automation of Electric Power Systems,2022,46(2): 24-32.

[7]熊宇峰,司杨,郑天文,等.基于主从博弈的工业园区综合能源系统氢储能优化配置[J].电工技术学报,2021,36(3): 507-516.Xiong Yufeng,Si Yang,Zheng Tianwen,et al.Optimal configuration of hydrogen storage in industrial park integrated energy system based on stackelberg game[J].Transactions of China Electrotechnical Society,2021,36(3): 507-516.

[8]邓杰,姜飞,王文烨,等.考虑动态能效模型的园区综合能源系统梯级优化运行[J].电网技术,2022,46(3): 1027-1038.Deng Jie,Jiang Fei,Wang Wenye,et al.Study on cascade optimization operation of park-level integrated energy system considering dynamic energy efficiency model[J].Power System Technology,2022,46(3): 1027-1038.

[9]Chen Changming,Wu Xueyan,Li Yan,et al.Distributionally robust day-ahead scheduling of parklevel integrated energy system considering generalized energy storages[J].Applied Energy,2021,302: 117493.

[10]赵海彭,苗世洪,李超,等.考虑冷热电需求耦合响应特性的园区综合能源系统优化运行策略研究[J].中国电机工程学报,2022,42(2): 573-588.Zhao Haipeng,Miao Shihong,Li Chao,et al.Research on optimal operation strategy for park-level integrated energy system considering cold-heat-electric demand coupling response characteristics[J].Proceedings of the CSEE,2022,42(2): 573-588.

[11]边晓燕,史越奇,裴传逊,等.计及经济性和可靠性因素的区域综合能源系统双层协同优化配置[J].电工技术学报,2021,36(21): 4529-4543.Bian Xiaoyan,Shi Yueqi,Pei Chuanxun,et al.Bilevel collaborative configuration optimization of integrated community energy system considering economy and reliability[J].Transactions of China Electrotechnical Society,2021,36(21): 4529-4543.

[12]王磊,周建平,朱刘柱,等.基于分布式模型预测控制的综合能源系统多时间尺度优化调度[J].电力系统自动化,2021,45(13): 57-65.Wang Lei,Zhou Jianping,Zhu Liuzhu,et al.Multitime-scale optimization scheduling of integrated energy system based on distributed model predictive control[J].Automation of Electric Power Systems,2021,45(13): 57-65.

[13]何畅,程杉,徐建宇,等.基于多时间尺度和多源储能的综合能源系统能量协调优化调度[J].电力系统及其自动化学报,2020,32(2): 77-84,97.He Chang,Cheng Shan,Xu Jianyu,et al.Coordinated optimal scheduling of integrated energy system considering multi-time scale and hybrid energy storage system[J].Proceedings of the CSU-EPSA,2020,32(2): 77-84,97.

[14]汤翔鹰,胡炎,耿琪,等.考虑多能灵活性的综合能源系统多时间尺度优化调度[J].电力系统自动化,2021,45(4): 81-90.Tang Xiangying,Hu Yan,Geng Qi,et al.Multi-timescale optimal scheduling of integrated energy system considering multi-energy flexibility[J].Automation of Electric Power Systems,2021,45(4): 81-90.

[15]Li Xiaozhu,Wang Weiqing,Wang Haiyun.Hybrid time-scale energy optimal scheduling strategy for integrated energy system with bilateral interaction with supply and demand[J].Applied Energy,2021,285: 116458.

[16]谢鹏,蔡泽祥,刘平,等.考虑多时间尺度不确定性耦合影响的风光储微电网系统储能容量协同优化[J].中国电机工程学报,2019,39(24): 7126-7136,7486.Xie Peng,Cai Zexiang,Liu Ping,et al.Cooperative optimization of energy storage capacity for renewable and storage involved microgrids considering multi time scale uncertainty coupling influence[J].Proceedings of the CSEE,2019,39(24): 7126-7136,7486.

[17]张大海,贠韫韵,王小君,等.考虑广义储能及光热电站的电热气互联综合能源系统经济调度[J].电力系统自动化,2021,45(19): 33-42.Zhang Dahai,Yun Yunyun,Wang Xiaojun,et al.Economic dispatch of integrated electricity-heat-gas energy system considering generalized energy storage and concentrating solar power plant[J].Automation of Electric Power Systems,2021,45(19): 33-42.

[18]程杉,黄天力,魏荣宗.含冰蓄冷空调的冷热电联供型微网多时间尺度优化调度[J].电力系统自动化,2019,43(5): 30-40.Cheng Shan,Huang Tianli,Wei Rongzong.Multitime-scale optimal scheduling of CCHP microgrid with ice-storage air-conditioning[J].Automation of Electric Power Systems,2019,43(5): 30-40.

[19]Wang L X,Zheng J H,Li M S,et al.Multi-time scale dynamic analysis of integrated energy systems: an individual-based model[J].Applied Energy,2019,237: 848-861.

[20]Watari D,Taniguchi I,Goverde H,et al.Multi-time scale energy management framework for smart PV systems mixing fast and slow dynamics[J].Applied Energy,2021,289: 116671.

[21]杨挺,赵黎媛,刘亚闯,等.基于深度强化学习的综合能源系统动态经济调度[J].电力系统自动化,2021,45(5): 39-47.Yang Ting,Zhao Liyuan,Liu Yachuang,et al.Dynamic economic dispatch for integrated energy system based on deep reinforcement learning[J].Automation of Electric Power Systems,2021,45(5): 39-47.

[22]Yang Ting,Zhao Liyuan,Li Wei,et al.Dynamic energy dispatch strategy for integrated energy system based on improved deep reinforcement learning[J].Energy,2021,235: 121377.

[23]聂欢欢,张家琦,陈颖,等.基于双层强化学习方法的多能园区实时经济调度[J].电网技术,2021,45(4): 1330-1336.Nie Huanhuan,Zhang Jiaqi,Chen Ying,et al.Realtime economic dispatch of community integrated energy system based on a double-layer reinforcement learning method[J].Power System Technology,2021,45(4): 1330-1336.

[24]Xu Zhengwei,Han Guangjie,Liu Li,et al.Multienergy scheduling of an industrial integrated energy system by reinforcement learning-based differential evolution[J].IEEE Transactions on Green Communications and Networking,2021,5(3): 1077-1090.

[25]乔骥,王新迎,张擎,等.基于柔性行动器-评判器深度强化学习的电-气综合能源系统优化调度[J].中国电机工程学报,2021,41(3): 819-832.Qiao Ji,Wang Xinying,Zhang Qing,et al.Optimal dispatch of integrated electricity-gas system with soft actor-critic deep reinforcement learning[J].Proceedings of the CSEE,2021,41(3): 819-832.

[26]Zhang Bin,Hu Weihao,Li Jinghua,et al.Dynamic energy conversion and management strategy for an integrated electricity and natural gas system with renewable energy: deep reinforcement learning approach[J].Energy Conversion and Management,2020,220: 113063.

[27]Zhang Xiangyu,Biagioni D,Cai Mengmeng,et al.An edge-cloud integrated solution for buildings demand response using reinforcement learning[J].IEEE Transactions on Smart Grid,2021,12(1): 420-431.

[28]倪爽,崔承刚,杨宁,等.基于深度强化学习的配电网多时间尺度在线无功优化[J].电力系统自动化,2021,45(10): 77-85.Ni Shuang,Cui Chenggang,Yang Ning,et al.Multitime-scale online optimization for reactive power of distribution network based on deep reinforcement learning[J].Automation of Electric Power Systems,2021,45(10): 77-85.

[29]Zhang Xi,Liu Youbo,Duan Jiajun,et al.DDPG-based multi-agent framework for SVC tuning in urban power grid with renewable energy resources[J].IEEE Transactions on Power Systems,2021,36(6): 5465-5475.

[30]刁涵彬,李培强,王继飞,等.考虑电/热储能互补协调的综合能源系统优化调度[J].电工技术学报,2020,35(21): 4532-4543.Diao Hanbin,Li Peiqiang,Wang Jifei,et al.Optimal dispatch of integrated energy system considering complementary coordination of electric/thermal energy storage[J].Transactions of China Electrotechnical Society,2020,35(21): 4532-4543.

[31]李山山,李华强,金智博,等.基于共享经济理念的园区分布式能源共享服务机制[J].中国电机工程学报,2022,42(1): 56-70.Li Shanshan,Li Huaqiang,Jin Zhibo,et al.Distributed energy sharing service mechanism for park based on the concept of sharing economy[J].Proceedings of the CSEE,2022,42(1): 56-70.

[32]陈剑龙.基于深度强化学习的微能源网能量管理策略研究[D].广州: 华南理工大学,2020.

[33]邱高,刘友波,许立雄,等.基于深度确定性策略梯度的电网断面极限传输能力动态趋优控制[J].中国电机工程学报,2021,41(15): 5128-5138.Qiu Gao,Liu Youbo,Xu Lixiong,et al.A deep deterministic policy gradient based-dynamic optimizing control for power system total transfer capability[J].Proceedings of the CSEE,2021,41(15): 5128-5138.

[34]刘俊峰,陈剑龙,王晓生,等.基于深度强化学习的微能源网能量管理与优化策略研究[J].电网技术,2020,44(10): 3794-3803.Liu Junfeng,Chen Jianlong,Wang Xiaosheng,et al.Energy management and optimization of multi-energy grid based on deep reinforcement learning[J].Power System Technology,2020,44(10): 3794-3803.

[35]Zhang Bin,Hu Weihao,Cao Di,et al.Soft actor-criticbased multi-objective optimized energy conversion and management strategy for integrated energy systems with renewable energy[J].Energy Conversion and Management,2021,243: 114381.

[36]郭明萱,穆云飞,肖迁,等.考虑电池寿命损耗的园区综合能源电/热混合储能优化配置[J].电力系统自动化,2021,45(13): 66-75.Guo Mingxuan,Mu Yunfei,Xiao Qian,et al.Optimal configuration of electric/thermal hybrid energy storage for park-level integrated energy system considering battery life loss[J].Automation of Electric Power Systems,2021,45(13): 66-75.